I en verden, hvor erhvervsvirksomheder støder mod hinanden for at være de første til at transformere deres forretningspraksis ved at anvende kunstig intelligens-løsninger, ser datamærkning ud til at være den eneste opgave, alle begynder at snuble over. Måske er det fordi kvaliteten af de data, du træner dine AI-modeller på, bestemmer deres nøjagtighed og succes.

Datamærkning eller dataannotering er aldrig en engangsbegivenhed. Det er en kontinuerlig proces. Der er ikke noget omdrejningspunkt, hvor du måske tror, du har trænet nok, eller at dine AI-modeller er nøjagtige til at opnå resultater.

Men hvor går AI's løfte om at udnytte nye muligheder galt? Nogle gange under datamærkningsprocessen.

Et af de største smertepunkter for virksomheder, der inkorporerer AI-løsninger, er dataannotering. Så lad os tage et kig på de 5 bedste datamærkningsfejl, der skal undgås.

Top 5 datamærkningsfejl, der skal undgås

Indsamler ikke nok data til projektet

Data er væsentlige, men de bør være relevante i forhold til dine projektmål. For at modellen skal give nøjagtige resultater, bør de data, den er trænet på, mærkes, kvalitetskontrolleres for at sikre nøjagtigheden.

Hvis du vil udvikle en fungerende, pålidelig AI-løsning, skal du tilføre den store mængder relevante data af høj kvalitet. Og du skal konstant føre disse data til dine maskinlæringsmodeller, så de kan forstå og korrelere forskellige stykker information, du giver.

Jo større datasæt du bruger, jo bedre vil forudsigelserne være.

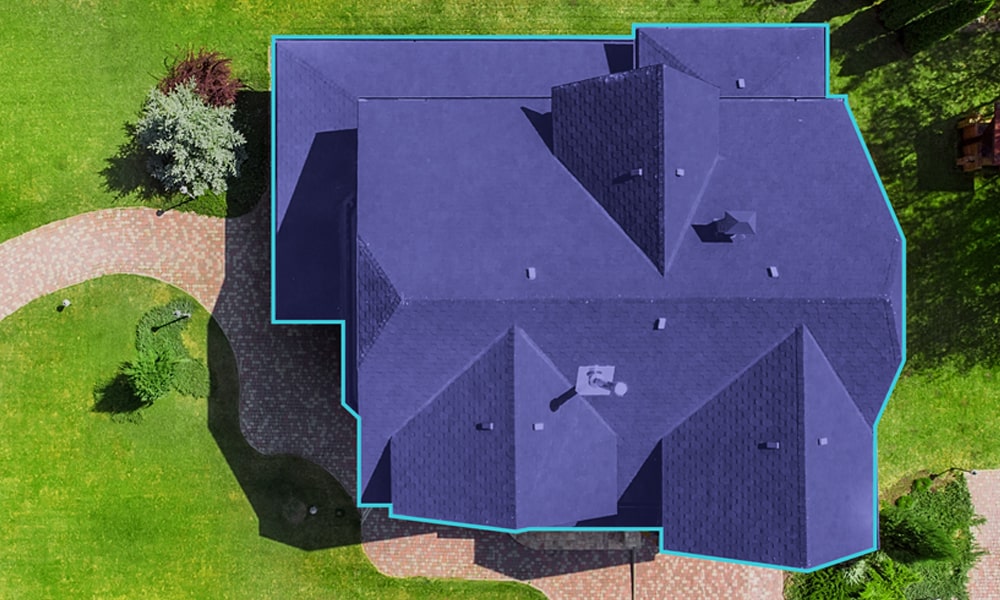

En faldgrube i datamærkningsprocessen er at indsamle meget få data for mindre almindelige variabler. Når du mærker billeder baseret på en almindeligt tilgængelig variabel i rådokumenterne, træner du ikke din deep learning AI-model på andre mindre almindelige variabler.

Deep learning-modeller kræver tusindvis af datastykker, for at modellen kan fungere rimeligt godt. For eksempel, når du træner en AI-baseret robotarm til at manøvrere komplekst maskineri, kan hver lille variation i jobbet kræve endnu et parti træningsdatasæt. Men indsamling af sådanne data kan være dyrt og nogle gange direkte umuligt og vanskeligt at kommentere for enhver virksomhed.

Validerer ikke datakvalitet

Selvom det er én ting at have data, er det også vigtigt at validere de datasæt, du bruger, for at sikre, at de er konsistente af høj kvalitet. Men virksomheder finder det udfordrende at erhverve kvalitetsdatasæt. Generelt er der to grundlæggende typer af datasæt - subjektive og objektive.

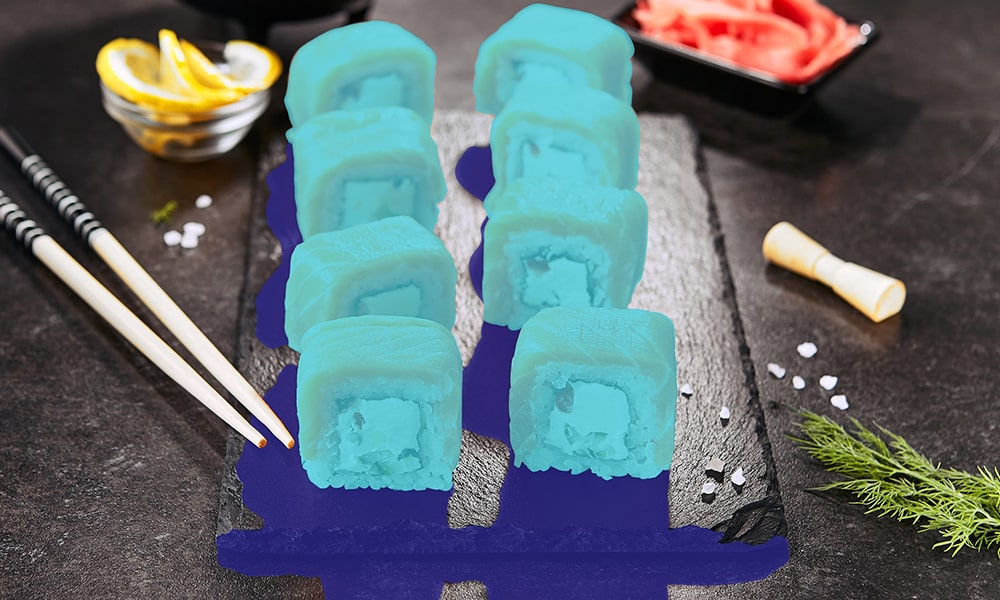

Ved mærkning af datasæt kommer etiketterens subjektive sandhed i spil. For eksempel kan deres erfaring, sprog, kulturelle fortolkninger, geografi og mere påvirke deres fortolkning af data. Uvægerligt vil hver labeler give et andet svar baseret på deres egne forudsætninger. Men subjektive data har ikke et 'rigtigt eller forkert svar' – det er derfor, arbejdsstyrken skal have klare standarder og retningslinjer, når de mærker billeder og andre data.

Udfordringen ved objektive data er risikoen for, at etiketteren ikke har domæneerfaring eller viden til at identificere de korrekte svar. Det er umuligt at gøre op med menneskelige fejl fuldstændigt, så det bliver vigtigt at have standarder og en lukket-loop feedback-metode.

Fokuserer ikke på Workforce Management

Maskinlæringsmodeller afhænger af store datasæt af forskellige typer, så der tages højde for hvert scenarie. Men succesfuld billedannotering kommer med sit eget sæt af udfordringer med arbejdsstyrkestyring.

Et stort problem er at styre en stor arbejdsstyrke, der manuelt kan behandle betydelige ustrukturerede datasæt. Det næste er at opretholde høje kvalitetsstandarder på tværs af arbejdsstyrken. Mange problemer kan beskæres under dataannoteringsprojekter.

Nogle er:

- Behovet for at uddanne nye etikettere i at bruge annotationsværktøjer

- Dokumentation af instruktioner i kodebogen

- Sikre, at kodebogen følges af alle teammedlemmer

- Definerer arbejdsgangen – alloker, hvem der gør hvad baseret på deres evner

- Krydstjek og løsning af tekniske problemer

- Sikring af kvalitet og validering af datasæt

- Giver gnidningsfrit samarbejde mellem labeler-teams

- Minimerer etiketter bias

For at sikre, at du sejler gennem denne udfordring, bør du forbedre dine kompetencer og kompetencer inden for arbejdsstyrkeledelse.

Ikke at vælge de rigtige datamærkningsværktøjer

Markedsstørrelsen på dataannoteringsværktøjerne var forbi $ 1 milliarder i 2020, og dette tal forventes at vokse med mere end 30 % CAGR i 2027. Den enorme vækst i datamærkningsværktøjer er, at det transformerer resultatet af kunstig intelligens og maskinlæring.

De anvendte værktøjsteknikker varierer fra et datasæt til et andet. Vi har bemærket, at de fleste organisationer begynder den dybe læringsproces ved at fokusere på at udvikle interne mærkningsværktøjer. Men meget hurtigt indser de, at efterhånden som annoteringsbehovet begynder at vokse, kan deres værktøjer ikke holde trit. Desuden er udvikling af interne værktøjer dyrt, tidskrævende og praktisk talt unødvendigt.

I stedet for at gå den konservative vej med manuel mærkning eller investere i at udvikle tilpassede mærkningsværktøjer, er det smart at købe enheder fra en tredjepart. Med denne metode er alt hvad du skal gøre at vælge det rigtige værktøj baseret på dit behov, de leverede tjenester og skalerbarhed.

Overholder ikke retningslinjerne for datasikkerhed

Overholdelse af datasikkerhed vil se en markant stigning snart, efterhånden som flere virksomheder indsamler store sæt ustrukturerede data. CCPA, DPA og GDPR er nogle af de internationale datasikkerhedsstandarder, der bruges af virksomheder.

Presset for overholdelse af sikkerhed er ved at vinde accept, fordi når det kommer til mærkning af ustrukturerede data, er der forekomster af personlige data til stede på billederne. Udover at beskytte individernes privatliv, er det også vigtigt at sikre, at data er sikret. Virksomhederne skal sørge for, at arbejderne uden sikkerhedsgodkendelse ikke har adgang til disse datasæt og ikke kan overføre eller pille ved dem i nogen form.

Sikkerhedsoverholdelse bliver et centralt smertepunkt, når det kommer til outsourcing af mærkningsopgaver til tredjepartsudbydere. Datasikkerhed øger projektets kompleksitet, og udbydere af mærkningstjenester skal overholde virksomhedens regler.

Så venter dit næste store AI-projekt på den rigtige datamærkningstjeneste?

Vi tror på, at ethvert AI-projekts succes afhænger af de datasæt, vi indlæser i maskinlæringsalgoritmen. Og hvis AI-projektet forventes at give nøjagtige resultater og forudsigelser, er dataannotering og mærkning af afgørende betydning. Ved outsourcing af dine dataanmærkningsopgaver, forsikrer vi dig om, at du effektivt kan løse disse udfordringer.

Med vores fokus på konsekvent at vedligeholde datasæt af høj kvalitet, tilbyde feedback i lukket kredsløb og administrere arbejdsstyrken effektivt, vil du være i stand til at levere førsteklasses AI-projekter, der giver et højere niveau af nøjagtighed.

[Læs også: In-house eller outsourcet dataannotering – hvilket giver bedre AI-resultater?]

Ved mærkning af datasæt kommer etiketterens subjektive sandhed i spil. For eksempel kan deres erfaring, sprog, kulturelle fortolkninger, geografi og mere påvirke deres fortolkning af data. Uvægerligt vil hver labeler give et andet svar baseret på deres egne forudsætninger. Men subjektive data har ikke et 'rigtigt eller forkert svar' – det er derfor, arbejdsstyrken skal have klare standarder og retningslinjer, når de mærker billeder og andre data.

Ved mærkning af datasæt kommer etiketterens subjektive sandhed i spil. For eksempel kan deres erfaring, sprog, kulturelle fortolkninger, geografi og mere påvirke deres fortolkning af data. Uvægerligt vil hver labeler give et andet svar baseret på deres egne forudsætninger. Men subjektive data har ikke et 'rigtigt eller forkert svar' – det er derfor, arbejdsstyrken skal have klare standarder og retningslinjer, når de mærker billeder og andre data.

Presset for overholdelse af sikkerhed er ved at vinde accept, fordi når det kommer til mærkning af ustrukturerede data, er der forekomster af personlige data til stede på billederne. Udover at beskytte individernes privatliv, er det også vigtigt at sikre, at data er sikret. Virksomhederne skal sørge for, at arbejderne uden sikkerhedsgodkendelse ikke har adgang til disse datasæt og ikke kan overføre eller pille ved dem i nogen form.

Presset for overholdelse af sikkerhed er ved at vinde accept, fordi når det kommer til mærkning af ustrukturerede data, er der forekomster af personlige data til stede på billederne. Udover at beskytte individernes privatliv, er det også vigtigt at sikre, at data er sikret. Virksomhederne skal sørge for, at arbejderne uden sikkerhedsgodkendelse ikke har adgang til disse datasæt og ikke kan overføre eller pille ved dem i nogen form.