Dataanmærkning eller datamærkning, som du ved, er en evig proces. Der er ingen, der definerer det øjeblik, du kunne fortælle, at du ville stoppe med at træne dine AI -moduler, fordi de er blevet helt præcise og hurtige til at levere resultater.

Selvom lanceringen af dit AI-drevne modul kun er en milepæl, sker AI-træning løbende efter lanceringen for at optimere resultater og effektivitet. På grund af dette er organisationer plaget af bekymring over at generere massive mængder af relevante data til deres maskinlæringsmoduler.

Det er dog ikke den bekymring, vi skal diskutere i dag. Vi vil undersøge de udfordringer, der opstår, når denne bekymring vedr generering af data er fast. Forestil dig, at du har utallige datagenereringspunkter. Det mere problematiske problem, du vil stå over for på dette tidspunkt, er annotering så store datamængder.

Skalerbar datamærkning er det, vi skal kaste lys over i dag, fordi de organisationer og teams, vi har talt med, alle har peget os på, at disse interessenter finder opbygning af maskintillid mere udfordrende end at generere data. Og som du ved, kan maskintillid kun opbygges gennem korrekt uddannede systemer, der understøttes af præcist kommenterede data. Så lad os se på 5 store bekymringer, der reducerer effektiviteten af datamærkningsprocesser.

5 udfordringer i den virkelige verden, der udvander indsatsen for datamærkning

Arbejdsstyrke ledelse

Vi har gentagne gange gentaget, at datamærkning ikke bare er tidskrævende, men også arbejdskrævende. Dataanmeldingseksperter bruger utallige timer på at rense ustrukturerede data, kompilere dem og gøre dem maskinlæsbare. Samtidig skal de sikre, at deres kommentarer er præcise og af høj kvalitet.

Så organisationer er klar til udfordringen med at afbalancere både kvalitet og kvantitet for at skære resultater, der gør en forskel og løser et formål. I sådanne tilfælde bliver styring af arbejdsstyrken ekstremt vanskelig og anstrengende. Mens outsourcing hjælper, virksomheder, der har dedikeret interne teams til dataarnnotering formål, står over for forhindringer som:

- Medarbejderuddannelse til datamærkning

- Fordeling af arbejdet på tværs af teams og fremme interoperabilitet

- Sporing af ydeevne og fremskridt på både mikro- og makroniveau

- Bekæmpelse af nedslidning og omskolering af nye medarbejdere

- Effektivisering af koordinering mellem dataforskere, annotatorer og projektledere

- Eliminering af kulturelle, sproglige og geografiske barrierer og fjernelse af bias fra operationelle økosystemer og mere

Sporing af økonomi

Budgettering er en af de mest afgørende faser i AI -uddannelse. Det definerer, hvor meget du er villig til at bruge på at bygge et AI -modul med hensyn til tech -stacken, ressourcer, personale og mere og hjælper dig derefter med at beregne nøjagtig RoI. Tæt på 26% af virksomhederne at venture i at udvikle AI -systemer mislykkes halvvejs på grund af forkert budgettering. Der er hverken gennemsigtighed om, hvor der pumpes penge ind, eller effektive metrics, der giver interessenter i realtid indsigt i, hvad deres penge bliver omsat til.

Små og mellemstore virksomheder er ofte fanget i dilemmaet om betaling pr. Projekt eller pr. Time og i smuthullet med at ansætte SMV'er til anmærkning formål vs rekruttering af en pulje af formidlere. Alle disse kan elimineres under budgetteringsprocessen.

Overholdelse af databeskyttelse og overholdelse

Mens antallet af anvendelsessager til AI stiger, skynder virksomheder sig at bølge og udvikle løsninger, der højner liv og erfaring. I den anden ende af spektret ligger en udfordring, som virksomheder i alle størrelser skal være opmærksomme på - bekymringer for databeskyttelse.

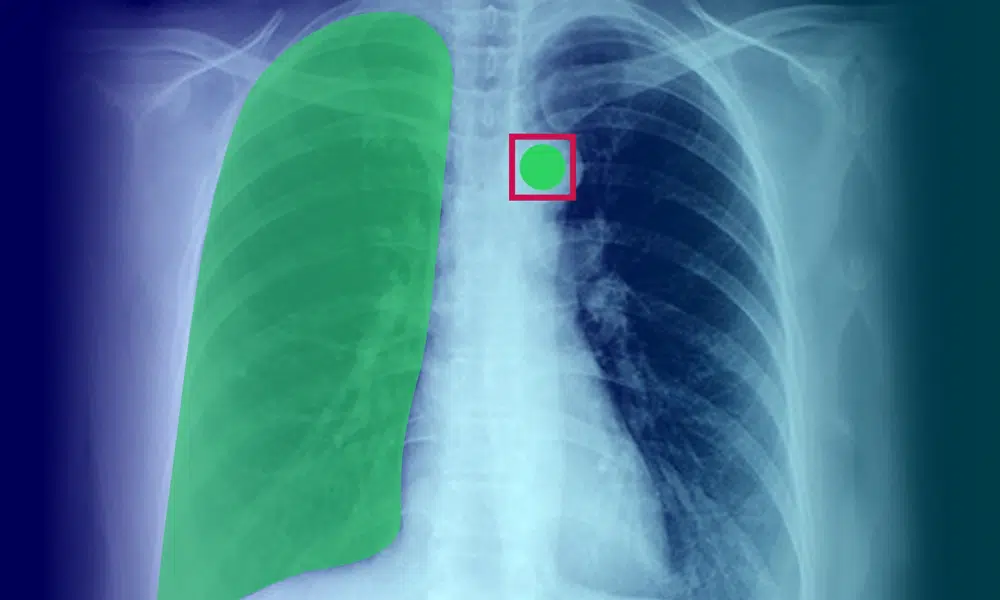

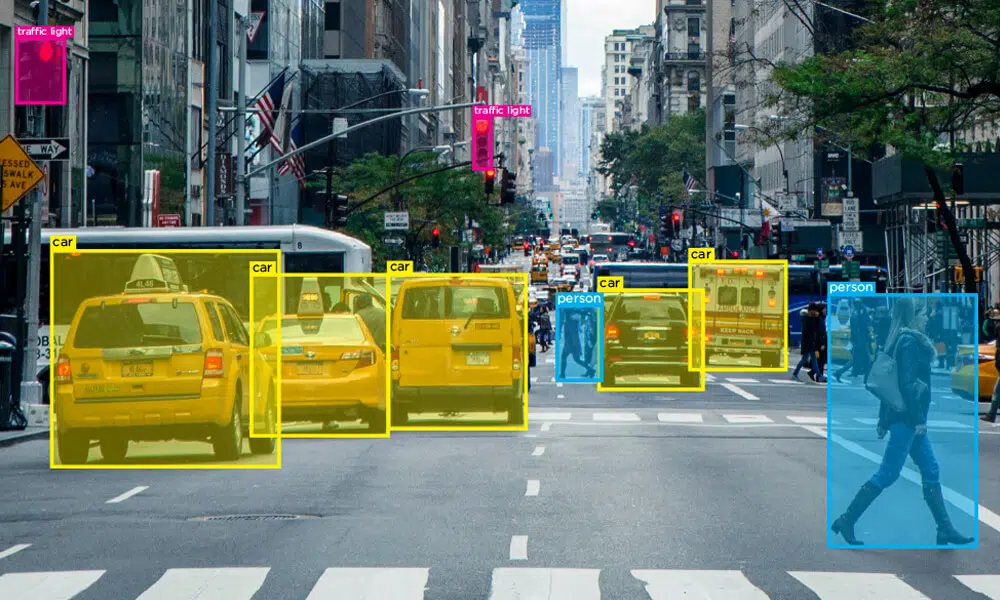

Du kender muligvis til GDPR, CCPA, DPA og andre retningslinjer, men der er nyere love og overholdelser, der udvikles og implementeres af nationer rundt om i verden. Når der genereres flere datamængder, bliver privatlivets fred afgørende i datakommentarer, da data fra sensorer og computersyn genererer data, der har ansigter på mennesker, fortrolige detaljer fra KYC -dokumenter, nummerplader af køretøjer, licensnumre og mere.

Dette presser behovet for korrekt vedligeholdelse af fortrolighedsstandarder og overholdelse af fair brug af fortrolige data. Teknisk set bør virksomheder garantere et sundt og sikkert miljø, der forhindrer uautoriseret adgang til data, brug af uautoriserede enheder i et datasikkert økosystem, ulovlig download af filer, overførsel til cloud-systemer og mere. Lovene om databeskyttelse er indviklede, og der skal udvises omhu for at sikre, at hvert eneste krav er opfyldt for at undgå juridiske konsekvenser.

Smarte værktøjer og assisterede kommentarer

Ud af de to forskellige typer annotationsmetoder - manuel og automatisk, er en hybrid annotationsmodel ideel til fremtiden. Dette skyldes, at AI -systemer er gode til at behandle enorme datamængder problemfrit, og mennesker er gode til at påpege fejl og optimere resultater.

AI-assisterede værktøjer og annoteringsteknikker er faste løsninger på de udfordringer, vi står over for i dag, da det gør livet for alle interessenter, der er involveret i processen, let. Smarte værktøjer giver virksomheder mulighed for at automatisere arbejdsopgaver, pipeline -styring, kvalitetskontrol af kommenterede data og tilbyde mere bekvemmelighed. Uden smarte værktøjer ville personalet stadig arbejde på forældede teknikker og presse menneskelige timer betydeligt til at fuldføre arbejdet.

Håndtering af konsistens i datakvalitet og kvantitet

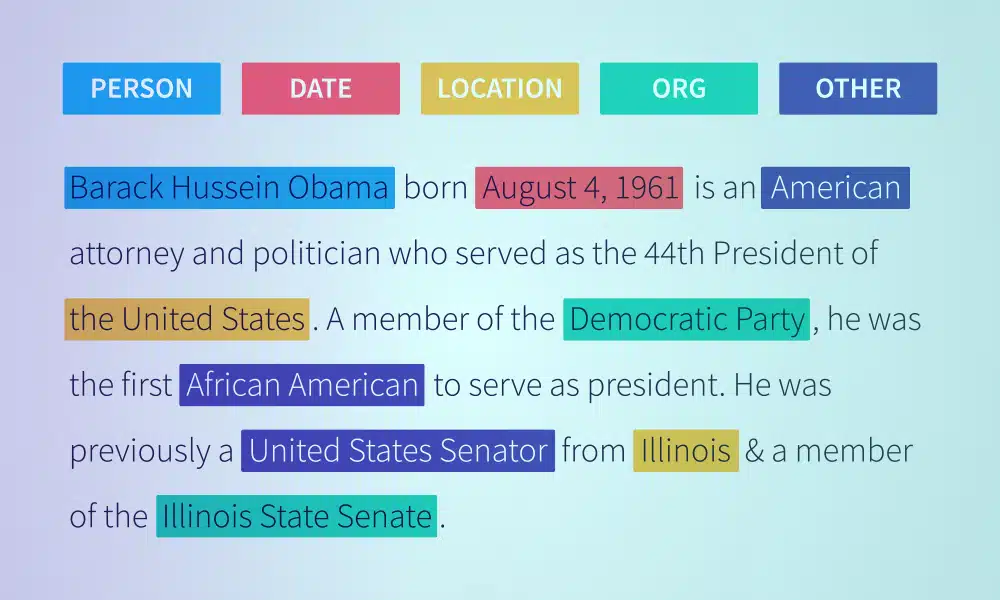

Et af de vigtige aspekter ved vurdering af datakvalitet er vurdering af definitionen af etiketter i datasæt. For de uindviede, lad os forstå, at der er to hovedtyper af datasæt -

- Objektive data - data, der er sande eller universelle, uanset hvem der ser på dem

- Og subjektive data - data, der kunne have flere opfattelser baseret på, hvem der har adgang til dem

For eksempel, mærkning et æble som et rødt æble er objektivt, fordi det er universelt, men tingene bliver komplicerede, når der er nuancerede datasæt i hånden. Overvej et vittigt svar fra en kunde på en anmeldelse. Annotatoren skal være smart nok til at forstå, om kommentaren er sarkastisk eller et kompliment for at mærke den i overensstemmelse hermed. Følelsesanalyse moduler behandles baseret på, hvad annotatoren har mærket. Så når flere øjne og sind er involveret, hvordan når et hold til enighed?

Hvordan kan virksomheder håndhæve retningslinjer og regler, der eliminerer forskelle og medfører en betydelig objektivitet i subjektive datasæt?

Indpakning op

Det er ret overvældende, ikke sandt, mængden af udfordringer, som forskere og annotatorer dagligt står over for? De bekymringer, vi har diskuteret hidtil, er blot en del af udfordringen, der stammer fra den konsekvente tilgængelighed af data. Der er meget mere i dette spektrum.

Forhåbentlig vil vi dog styre foran alt dette takket være udviklingen af processer og systemer i datakommentarer. Der er altid outsourcing (shaip) tilgængelige muligheder, der giver dig data af høj kvalitet baseret på dine krav.

Vi har gentagne gange gentaget, at datamærkning ikke bare er tidskrævende, men også arbejdskrævende. Dataanmeldingseksperter bruger utallige timer på at rense ustrukturerede data, kompilere dem og gøre dem maskinlæsbare. Samtidig skal de sikre, at deres kommentarer er præcise og af høj kvalitet.

Vi har gentagne gange gentaget, at datamærkning ikke bare er tidskrævende, men også arbejdskrævende. Dataanmeldingseksperter bruger utallige timer på at rense ustrukturerede data, kompilere dem og gøre dem maskinlæsbare. Samtidig skal de sikre, at deres kommentarer er præcise og af høj kvalitet. Du kender muligvis til GDPR, CCPA, DPA og andre retningslinjer, men der er nyere love og overholdelser, der udvikles og implementeres af nationer rundt om i verden. Når der genereres flere datamængder, bliver privatlivets fred afgørende i datakommentarer, da data fra sensorer og computersyn genererer data, der har ansigter på mennesker, fortrolige detaljer fra KYC -dokumenter, nummerplader af køretøjer, licensnumre og mere.

Du kender muligvis til GDPR, CCPA, DPA og andre retningslinjer, men der er nyere love og overholdelser, der udvikles og implementeres af nationer rundt om i verden. Når der genereres flere datamængder, bliver privatlivets fred afgørende i datakommentarer, da data fra sensorer og computersyn genererer data, der har ansigter på mennesker, fortrolige detaljer fra KYC -dokumenter, nummerplader af køretøjer, licensnumre og mere.