Den mest værdifulde vare for virksomheder i disse dage er data. Da organisationer og enkeltpersoner fortsætter med at generere enorme mængder data i sekundet, er det ikke nok at fange dataene. Du skal analysere, transformere og udtrække meningsfuld indsigt fra dataene. Men knap nok 37-40% af virksomheder analyserer deres data, og 43 % af beslutningstagere i it-virksomheder frygter tilstrømningen af data, der potentielt kan overvælde deres datainfrastruktur.

Med behovet for at træffe hurtige datadrevne beslutninger og overvinde udfordringerne med uensartethed mellem datakilder, bliver det afgørende vigtigt for organisationer at udvikle en datainfrastruktur, der kan lagre, udtrække, analysere og transformere data effektivt.

Der er et presserende behov for at have et system, der kan overføre data fra kilden til lagersystemet og analysere og behandle dem i realtid. AI-datapipeline tilbyder netop det.

Hvad er en datapipeline?

En datapipeline er en gruppe af komponenter, der indtager eller indtager data fra forskellige kilder og overfører dem til en forudbestemt lagerplacering. Men før dataene overføres til depotet, gennemgår de forbehandling, filtrering, standardisering og transformation.

Hvordan bruges datapipelines i maskinlæring?

Pipelinen betegner workflowautomatisering i et ML-projekt ved at muliggøre datatransformation til modellen. En anden form for datapipeline til AI fungerer ved at dele arbejdsgangene op i flere selvstændige og genanvendelige dele, der kan kombineres til en model.

ML-datapipelines løser tre problemer med volumen, versionering og variation.

I en ML-pipeline giver det udvikleren mulighed for at designe en ny workflow, da workflowet er abstraheret i flere uafhængige tjenester ved blot at vælge og vælge det særlige element, der er nødvendigt, mens de andre dele bevares som sådan.

Projektets resultat, prototypedesign og model træning defineres under kodeudviklingen. Dataene indsamles fra forskellige kilder, mærkes og forberedes. De mærkede data bruges til test, forudsigelsesovervågning og implementering i produktionsstadiet. Modellen evalueres ved at sammenligne trænings- og produktionsdata.

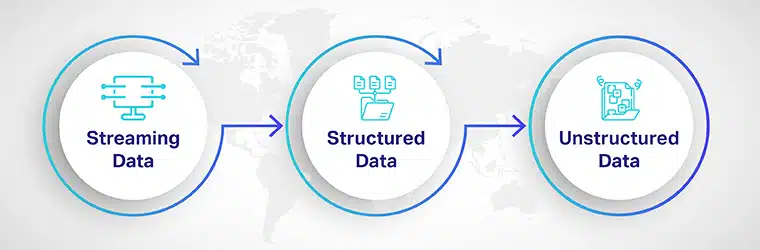

De typer af data, der bruges af rørledninger

En maskinlæringsmodel kører på livsnerven i datapipelines. For eksempel bruges en datapipeline til dataindsamling, rengøring, bearbejdning og lagring af data, der vil blive brugt til træning og test af modellerne. Da data indsamles fra både forretnings- og forbrugersiden, kan du blive bedt om at analysere data i flere filformater og hente dem fra flere lagersteder.

Så før du planlægger din kodestak, bør du vide, hvilken type data du vil behandle. Datatyperne, der bruges til at behandle ML-pipelines, er:

Streaming data: Live inputdata bruges til mærkning, forarbejdning og transformation. Det bruges til vejrudsigter, økonomiske forudsigelser og sentimentanalyse. Streaming data gemmes normalt ikke i en datasæt eller lagersystem, fordi det behandles i realtid.

Strukturerede data: Det er højt organiserede data, der er lagret i datavarehuse. Disse tabeldata er let søgbare og genfindelige til analyse.

Ustrukturerede data: Det tegner sig for næsten 80 % af alle data genereret af virksomheder. Det inkluderer tekst, lyd og video. Denne type data bliver ekstremt vanskelig at gemme, administrere og analysere, da den mangler struktur eller format. De nyeste teknologier, såsom AI og ML, bliver brugt til at transformere ustrukturerede data til et struktureret layout til bedre brug.

Hvordan bygger man en skalerbar datapipeline til at træne ML-modeller?

Der er tre grundlæggende trin i opbygningen af en skalerbar pipeline,

Dataopdagelse: Før dataene føres ind i systemet, skal de opdages og klassificeres baseret på karakteristika som værdi, risiko og struktur. Da der kræves en lang række informationer for at træne ML-algoritmen, AI data platforme bliver brugt til at trække information fra heterogene kilder, såsom databaser, cloud-systemer og brugerinput.

Dataindtagelse: Automatisk dataindtagelse bruges til at udvikle skalerbare datapipelines ved hjælp af webhooks og API-kald. De to grundlæggende tilgange til dataindtagelse er:

- Batch-indtagelse: Ved batch-indtagelse tages batches eller grupper af information som svar på en form for en trigger, såsom efter nogen tid eller efter at have nået en bestemt filstørrelse eller et bestemt antal.

- Streamingoptagelse: Med streamingoptagelse trækkes dataene ind i pipelinen i realtid, så snart de er genereret, opdaget og klassificeret.

Datarensning og transformation: Da de fleste af de indsamlede data er ustrukturerede, er det vigtigt at få dem renset, adskilt og identificeret. Det primære formål med datarensning før transformation er at fjerne duplikering, dummy-data og korrupte data, så kun de mest nyttige data er tilbage.

Forbehandling:

I dette trin bliver de ustrukturerede data kategoriseret, formateret, klassificeret og gemt til behandling.

Modelbehandling og -styring:

I dette trin trænes, testes og behandles modellen ved hjælp af de indlæste data. Modellen er forfinet ud fra domæne og krav. I modelstyring er koden gemt i en version, der hjælper med en hurtigere udvikling af maskinlæringsmodellen.

Modelimplementering:

I modelimplementeringstrinnet er kunstig intelligens løsningen er implementeret til brug for virksomheder eller slutbrugere.

Datapipelines – Fordele

Datapipelining hjælper med at udvikle og implementere smartere, mere skalerbare og mere nøjagtige ML-modeller i en væsentlig kortere periode. Nogle fordele ved ML-datapipelining inkluderer

Optimeret planlægning: Planlægning er vigtig for at sikre, at dine maskinlæringsmodeller kører problemfrit. Efterhånden som ML skaleres op, vil du opdage, at visse elementer i ML-pipelinen bruges flere gange af teamet. For at reducere beregningstiden og eliminere koldstart kan du planlægge implementeringen af de ofte brugte algoritmekald.

Teknologi, rammer og sproguafhængighed: Hvis du bruger en traditionel monolitisk softwarearkitektur, skal du være konsekvent med kodningssproget og sørge for at indlæse alle de nødvendige afhængigheder samtidigt. Men med en ML-datapipeline, der bruger API-endepunkter, er de forskellige dele af koden skrevet på flere forskellige sprog og bruger deres specifikke rammer.

Den største fordel ved at bruge en ML-pipeline er evnen til at skalere initiativet ved at tillade, at dele af modellen kan genbruges flere gange på tværs af teknologistakken, uanset rammen eller sproget.

Datapipelines udfordringer

Det er ikke let at skalere AI-modeller fra test og udvikling til implementering. I testscenarier kan forretningsbrugere eller kunder være meget mere krævende, og sådanne fejl kan være dyre for virksomheden. Nogle udfordringer ved datapipelining er:

Rengørings- og klargøringsudfordringer: Udover de tekniske udfordringer ved datapipelining er der udfordringen med at rense og dataforberedelse. Det rådata bør udarbejdes i skala, og hvis mærkningen ikke er udført præcist, kan det føre til problemer med AI-løsningen.

Organisatoriske udfordringer: Når en ny teknologi introduceres, opstår det første store problem på det organisatoriske og kulturelle niveau. Medmindre der er en kulturel ændring, eller folk er forberedt før implementering, kan det betyde undergang for AI pipeline projekt.

Datasikkerhed: Når du skalerer dit ML-projekt, kan estimering af datasikkerhed og -styring udgøre et stort problem. Siden oprindeligt ville en stor del af dataene blive gemt på et enkelt sted; der kan være problemer med, at det bliver stjålet, udnyttet eller åbnet op for nye sårbarheder.

Opbygning af en datapipeline bør være i overensstemmelse med dine forretningsmål, skalerbare ML-modelkrav og det niveau af kvalitet og konsistens, du har brug for.

Opsætning af en skalerbar datapipeline til maskinlæringsmodeller kan være udfordrende, tidskrævende og kompleks. Shaip gør hele processen nemmere og fejlfri. Med vores omfattende dataindsamlingserfaring vil partnerskab med os hjælpe dig med at levere hurtigere, højtydende, integreret og end-to-end maskinlæringsløsninger til en brøkdel af prisen.