Nøglen til at overvinde hindringer for AI-udvikling

Mere pålidelige data

Introduktion

Kunstig intelligens begyndte at fange fantasier, da Tin Man fra “The Wizard of Oz” ramte sølvskærmen i 1939, og den har kun fået et fastere fodfæste i tidsgeisten siden da. I applikationen har AI-produkter dog gennemgået regelmæssige boom-and-bust-cyklusser, der hidtil har forhindret de mest indflydelsesrige adoptioner.

I løbet af højkonjunkturen har ingeniører og forskere gjort enorme fremskridt, men når deres ambitioner uundgåeligt overstiger de tilgængelige datakapaciteter på det tidspunkt, har en periode med dvale fulgt. Heldigvis har den eksponentielle stigning i computerkraft, som profeteret af Moores lov i 1965, for det meste vist sig at være nøjagtig, og betydningen af denne stigning er vanskelig at overdrive.

Læs e -bogen: Nøglen til at overvinde forhindringer for AI -udvikling, eller download en PDF -version af e -bogen.

Nøglen til at overvinde AI-udviklingshindringer: mere pålidelige data

I dag har den gennemsnitlige person nu millioner af gange mere computerkraft i lommen, end NASA måtte trække månelandingen ud i 1969. Den samme allestedsnærværende enhed, der bekvemt viser en overflod af computerkraft, opfylder også en anden forudsætning for AIs guldalder: en overflod af data. Ifølge indsigter fra Information Overload Research Group blev 90% af verdens data oprettet i de sidste to år. Nu hvor den eksponentielle vækst i computerkraft endelig er konvergeret med lige så meteorisk vækst i genereringen af data, eksploderer AI-datainnovationer så meget, at nogle eksperter tror, at de vil starte en fjerde industrielle revolution.

Data fra National Venture Capital Association indikerer, at AI-sektoren oplevede en rekordinvestering på 6.9 milliarder dollars i første kvartal af 2020. Det er ikke svært at se potentialet i AI-værktøjer, fordi det allerede bliver tappet rundt omkring os. Nogle af de mere synlige brugssituationer til AI-produkter er anbefalingsmotorer bag vores yndlingsapplikationer som Spotify og Netflix. Selvom det er sjovt at opdage en ny kunstner at lytte til eller et nyt tv-show at binge-watch, er disse implementeringer ret lave. Andre algoritmer vurderer testresultater - dels bestemmer, hvor studerende accepteres på college - og stadig andre skifter gennem kandidatresuméer og beslutter, hvilke ansøgere der får et bestemt job. Nogle AI-værktøjer kan endda have liv-eller-død-implikationer, såsom AI-modellen, der screener for brystkræft (som overgår læger).

På trods af stabil vækst i både virkelige eksempler på AI-udvikling og antallet af startups, der kæmper for at skabe den næste generation af transformationsværktøjer, er der stadig udfordringer med hensyn til effektiv udvikling og implementering. Især er AI-output kun så nøjagtigt som input tillader, hvilket betyder, at kvalitet er altafgørende.

Udfordringen med inkonsekvent datakvalitet i AI-løsninger

Der genereres faktisk en utrolig mængde data hver dag: 2.5 quintillion byte, ifølge Social Media Today. Men det betyder ikke, at det hele er værd at træne din algoritme. Nogle data er ufuldstændige, andre er af lav kvalitet, og nogle er bare unøjagtige, så brug af nogen af disse defekte oplysninger vil resultere i de samme træk ud af din (dyre) AI-datainnovation. Ifølge forskning fra Gartner vil omkring 85% af AI-projekter oprettet inden 2022 producere unøjagtige resultater på grund af forudindtagne eller unøjagtige data. Mens du let kan springe over en sanganbefaling, der ikke passer til din smag, har andre unøjagtige algoritmer en betydelig økonomisk og velrenommeret pris.

I 2018 begyndte Amazon at bruge et AI-drevet ansættelsesværktøj, der var i produktion siden 2014, der havde en stærk og umiskendelig bias mod kvinder. Det viser sig, at de computermodeller, der ligger til grund for værktøjet, blev trænet ved hjælp af cv'er, der blev sendt til virksomheden i løbet af et årti. Fordi de fleste tekniske ansøgere var mænd (og stadig er, måske på grund af denne teknologi), besluttede algoritmen at straffe cv'er med "kvinders" inkluderet hvor som helst - for eksempel kvindefodboldkaptajn eller kvindeforretningsgruppe. Det besluttede endda at straffe ansøgerne fra to kvindeskoler. Amazon hævder, at værktøjet aldrig blev brugt som det eneste kriterium for evaluering af potentielle kandidater, men alligevel kiggede rekrutterere på anbefalingsmotoren, når de ledte efter nye ansættelser.

Amazon-ansættelsesværktøjet blev i sidste ende skrottet efter mange års arbejde, men lektionen dvæler og understreger vigtigheden af datakvalitet, når du træner algoritmer og AI-værktøjer. Hvordan ser data af høj kvalitet ud? Kort sagt kontrollerer det disse fem felter:

1. Relevant

For at blive betragtet som høj kvalitet skal data bringe noget værdifuldt i beslutningsprocessen. Er der en sammenhæng mellem en jobansøgeres status som statsmester i stangspringer og deres præstationer på arbejdspladsen? Det er muligt, men det virker meget usandsynligt. Ved at udrydde data, der ikke er relevante, kan en algoritme fokusere på at sortere gennem de oplysninger, der faktisk påvirker resultaterne.

2. Præcis

De data, du bruger, skal repræsentere nøjagtigt de ideer, du tester. Hvis ikke, er det ikke det værd. For eksempel trænede Amazon sin ansættelsesalgoritme ved hjælp af 10 års ansøgningsresultater, men det er uklart, om virksomheden først bekræftede oplysningerne om disse resuméer. Undersøgelse fra referencekontrolfirmaet Checkster viser, at 78% af ansøgerne lyver eller vil overveje at lyve på en jobansøgning. Hvis en algoritme f.eks. Tager beslutninger om anbefaling ved hjælp af en kandidats GPA, er det en god ide først at bekræfte ægtheden af disse tal. Denne proces ville tage tid og penge, men det ville også utvivlsomt forbedre nøjagtigheden af dine resultater.

3. Korrekt organiseret og kommenteret

I tilfælde af en ansættelsesmodel baseret på cv er annotering relativt let. På en måde kommer et cv forud kommenteret, selvom der uden tvivl ville være undtagelser. De fleste ansøgere angiver deres joberfaring under overskriften "Erfaring" og relevante færdigheder under "Færdigheder." I andre situationer, såsom screening af kræft, vil data imidlertid være meget mere varierede. Oplysninger kan komme i form af medicinsk billeddannelse, resultaterne af en fysisk screening eller endda en samtale mellem læge og patient om familiens sundhedshistorie og tilfælde af kræft, blandt andre former for data. For at disse oplysninger kan bidrage til en nøjagtig detektionsalgoritme, skal de omhyggeligt organiseres og kommenteres for at sikre, at AI-modellen lærer at foretage nøjagtige forudsigelser baseret på de rigtige slutninger.

4. Opdateret

Amazon forsøgte at skabe et værktøj, der ville spare tid og penge ved at gengive de samme ansættelsesbeslutninger, som mennesker tager på langt kortere tid. For at gøre anbefalingerne så nøjagtige som muligt skal data holdes ajour. Hvis et firma en gang demonstrerede en præference for kandidater med evnen til at reparere skrivemaskiner, for eksempel, ville disse historiske ansættelser sandsynligvis ikke have meget at gøre med egnetheden hos nutidige jobansøgere til nogen form for rolle. Som et resultat ville det være klogt at fjerne dem.

5. Passende forskelligartet

Amazon-ingeniører valgte at træne en algoritme med en pulje af ansøgere, der var overvældende mandlige. Denne beslutning var en kritisk fejl, og den blev ikke mindre uhyggelig af det faktum, at det var de cv'er, som virksomheden havde til rådighed på det tidspunkt. Amazon-ingeniører kunne have indgået et samarbejde med anerkendte organisationer med lignende ledige stillinger, der havde modtaget flere kvindelige jobansøgere for at kompensere for manglen, eller det kunne have været kunstigt nedskære antallet af mænds cv'er for at matche antallet af kvinder og trænet og styret algoritmen med en mere nøjagtig repræsentation af befolkningen. Pointen er, at data mangfoldighed er nøglen, og medmindre der gøres en samlet indsats for at eliminere bias i input, vil forudindtagne output forrang.

Det er klart, at data af høj kvalitet ikke bare vises ud af ingenting. I stedet skal det nøje kurateres med de tilsigtede resultater i tankerne. I AI-feltet bliver det ofte sagt, at "skrald ind betyder skrald ud." Denne erklæring er sand, men det undervurderer noget vigtigheden af kvalitet. AI kan behandle utrolige mængder information og gøre det til alt fra lagervalg til ansættelsesanbefalinger til medicinske diagnoser. Denne kapacitet overgår langt menneskers evne, hvilket også betyder, at den forstørrer resultaterne. En partisk menneskelig rekrutterer kunne kun overse så mange kvinder, men en partisk AI-rekrutterer kunne overse dem alle. I den forstand betyder affald ikke bare affald ude - det betyder, at en lille mængde "affaldsdata" kan blive til en hel losseplads.

Navigering af komplekse krav til overholdelse

Som om at finde kvalitetsdata ikke var svært nok, er nogle af de industrier, der står for at få mest ud af AI-datainnovationer, også de mest regulerede. Sundhedspleje er måske det bedste eksempel, og mens en undersøgelse fra HIT Infrastructure viste, at 91% af industriens insidere mener, at teknologien kunne forbedre adgangen til pleje, er optimismen tempereret af det faktum, at 75% ser det som en trussel mod patientsikkerhed og privatlivets fred. - og patienter er ikke de eneste i fare.

De omfattende regler vedtaget gennem Health Insurance Portability and Accountability Act skærer nu hinanden med forskellige lokale dataoverholdelseshindringer, såsom Europas generelle databeskyttelsesforordning, California Consumer Privacy Act i USA og persondatabeskyttelsesloven i Singapore. Disse lokale regler vil blive tilsluttet af mange flere, og da telesundhed fremstår som en mere vigtig kilde til sundhedsdata, er det sandsynligt, at regler vil få et endnu strammere greb om patientdata under transit. Som et resultat vil Shaips sikre og kompatible cloudplatform vise sig at være et endnu mere værdifuldt middel til at samle og få adgang til sundhedsdata for at træne AI-produkter.

Personligt identificerbare oplysninger kan være en væsentlig trussel mod din AI-udvikling, men endda en fuldstændig implementering er i fare, hvis den ikke kan levere den slags nøjagtige resultater, der kun kommer med forskellige træningsdata. En 2020-undersøgelse i Journal of the American Medical Association viste, at maskinindlæringsalgoritmer inden for det medicinske område oftest trænes med data fra patienter i Californien, New York og Massachusetts. I betragtning af at disse patienter repræsenterer mindre end en femtedel af den amerikanske befolkning, for ikke at sige noget om resten af verden, er det svært at forestille sig, hvordan disse modeller kunne producere andet end partiske resultater.

Overvinde AI-udviklingshindringer

AI-udviklingsindsats inkluderer betydelige hindringer, uanset hvilken industri de finder sted i, og processen med at komme fra en mulig idé til et vellykket produkt er fyldt med vanskeligheder. Mellem udfordringerne ved at erhverve de rigtige data og behovet for at anonymisere dem for at overholde alle relevante regler, kan det føles som at konstruere og træne en algoritme er den nemme del.

For at give din organisation alle fordele, der er nødvendige i bestræbelserne på at designe en banebrydende ny AI-udvikling, vil du overveje at samarbejde med et firma som Shaip. Chetan Parikh og Vatsal Ghiya grundlagde Shaip for at hjælpe virksomheder med at konstruere de slags løsninger, der kunne omdanne sundhedsydelser i USA. Efter mere end 16 år i erhvervslivet er vores firma vokset til at omfatte mere end 600 teammedlemmer, og vi har arbejdet med hundreder af kunder til at gøre overbevisende ideer til AI-løsninger.

Med vores medarbejdere, processer og platform, der arbejder for din organisation, kan du straks låse op for følgende fire fordele og katapultere dit projekt mod en vellykket afslutning:

1. Evnen til at befri dine dataforskere

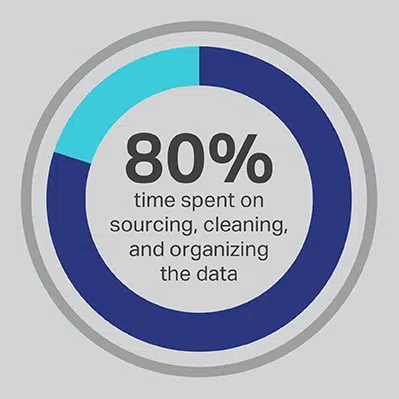

Det er ikke til at komme uden om, at AI -udviklingsprocessen tager en betydelig investering af tid, men du kan altid optimere de funktioner, dit team bruger mest tid på at udføre. Du hyrede dine dataforskere, fordi de er eksperter i udviklingen af avancerede algoritmer og maskinlæringsmodeller, men forskningen viser konsekvent, at disse medarbejdere faktisk bruger 80% af deres tid på at skaffe, rense og organisere de data, der driver projektet. Mere end tre fjerdedele (76%) af dataforskere rapporterer, at disse verdslige dataindsamlingsprocesser også tilfældigvis er deres mindst foretrukne dele af jobbet, men behovet for kvalitetsdata efterlader kun 20% af deres tid til egentlig udvikling, hvilket er det mest interessante og intellektuelt stimulerende arbejde for mange dataforskere. Ved at skaffe data via en tredjepartsleverandør som Shaip, kan en virksomhed lade sine dyre og talentfulde dataingeniører outsource deres arbejde som datevagter og i stedet bruge deres tid på dele af AI-løsninger, hvor de kan producere mest værdi.

2. Evnen til at opnå bedre resultater

At stole på open source-data er en anden almindelig genvej, der kommer med sit eget sæt faldgruber. Manglende differentiering er et af de største problemer, fordi en algoritme, der trænes ved hjælp af open source-data, lettere replikeres end en, der er bygget på licenserede datasæt. Ved at gå denne rute inviterer du konkurrence fra andre deltagere i rummet, der til enhver tid kan underbære dine priser og tage markedsandele. Når du stoler på Shaip, får du adgang til de højeste kvalitetsdata samlet af en dygtig administreret arbejdsstyrke, og vi kan give dig en eksklusiv licens til et brugerdefineret datasæt, der forhindrer konkurrenter i let at genskabe din hårdt vundne intellektuelle ejendom.

3. Adgang til erfarne fagfolk

Med domæneeksperter, der identificerer, organiserer, kategoriserer og mærker data til dig, ved du, at de oplysninger, der bruges til at træne din algoritme, kan give de bedst mulige resultater. Vi udfører også regelmæssig kvalitetssikring for at sikre, at data lever op til de højeste standarder og vil fungere som tilsigtet ikke kun i et laboratorium, men også i en reel situation.

4. En accelereret tidslinje for udvikling

AI-udvikling sker ikke natten over, men det kan ske hurtigere, når du samarbejder med Shaip. Intern dataindsamling og -notering skaber en betydelig operationel flaskehals, der holder resten af udviklingsprocessen. Arbejdet med Shaip giver dig øjeblikkelig adgang til vores enorme bibliotek med brugsklare data, og vores eksperter er i stand til at hente enhver form for yderligere input, du har brug for, med vores dybe brancheviden og globale netværk. Uden byrden ved sourcing og annotering kan dit team straks komme i gang med den faktiske udvikling, og vores træningsmodel kan hjælpe med at identificere tidlige unøjagtigheder for at reducere de iterationer, der er nødvendige for at nå nøjagtighedsmålene.

Hvis du ikke er klar til at outsource alle aspekter af din datastyring, tilbyder Shaip også en skybaseret platform, der hjælper teams med at producere, ændre og kommentere forskellige typer data mere effektivt, herunder support til billeder, video, tekst og lyd . ShaipCloud inkluderer en række intuitive værktøjer til validering og workflow, såsom en patenteret løsning til at spore og overvåge arbejdsbelastninger, et transkriptionsværktøj til transskription af komplekse og vanskelige lydoptagelser og en kvalitetskontrolkomponent for at sikre kompromisløs kvalitet. Bedst af alt er det skalerbart, så det kan vokse, efterhånden som de forskellige krav til dit projekt øges.

Alderen for AI-innovation er kun lige begyndt, og vi vil se utrolige fremskridt og innovationer i de kommende år, der har potentialet til at omforme hele industrier eller endda ændre samfundet som helhed. Hos Shaip ønsker vi at bruge vores ekspertise til at fungere som en transformerende kraft, der hjælper de mest revolutionerende virksomheder i verden med at udnytte kraften i AI-løsninger til at nå ambitiøse mål.

Vi har stor erfaring inden for sundhedsapplikationer og AI, men vi har også de nødvendige færdigheder til at træne modeller til næsten enhver form for anvendelse. For mere information om, hvordan Shaip kan hjælpe med at tage dit projekt fra idé til implementering, se på de mange ressourcer, der er tilgængelige på vores hjemmeside eller nå ud til os i dag.