Hvad er træningsdata i maskinlæring:

Definition, fordele, udfordringer, eksempler og datasæt

Den ultimative køberguide 2023

Introduktion

I verden af kunstig intelligens og maskinlæring er datatræning uundgåelig. Dette er den proces, der gør maskinlæringsmoduler nøjagtige, effektive og fuldt funktionelle. I dette indlæg udforsker vi detaljeret, hvad AI -træningsdata er, uddannelsesdatakvalitet, dataindsamling og licensering og mere.

Det anslås, at en voksen i gennemsnit tager beslutninger om livet og hverdagens ting baseret på tidligere læring. Disse kommer til gengæld fra livserfaringer formet af situationer og mennesker. I bogstavelig forstand er situationer, tilfælde og mennesker intet andet end data, der kommer ind i vores sind. Når vi akkumulerer mange års data i form af erfaring, har det menneskelige sind en tendens til at træffe sømløse beslutninger.

Hvad formidler dette? Disse data er uundgåelige i læring.

Ligesom hvordan et barn har brug for en etiket kaldet et alfabet for at forstå bogstaverne A, B, C, D, skal en maskine også forstå de data, den modtager.

Det er præcis hvad Artificial Intelligence (AI) uddannelse handler om. En maskine er ikke anderledes end et barn, der endnu ikke har lært ting af det, de er ved at blive undervist i. Maskinen ved ikke at skelne mellem en kat og en hund eller en bus og en bil, fordi de endnu ikke har oplevet disse ting eller er blevet lært, hvordan de ser ud.

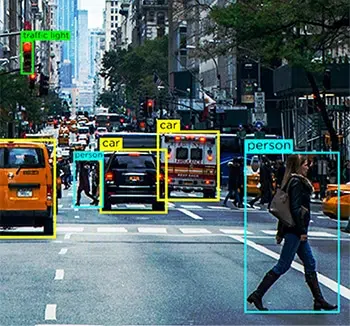

Så for en person, der bygger en selvkørende bil, er den primære funktion, der skal tilføjes, systemets evne til at forstå alle de hverdagslige elementer, bilen kan støde på, så køretøjet kan identificere dem og træffe passende kørselsbeslutninger. Det er her AI-træningsdata kommer i spil.

I dag tilbyder kunstige intelligensmoduler os mange bekvemmeligheder i form af anbefalingsmotorer, navigation, automatisering og mere. Alt dette sker på grund af AI -datatræning, der blev brugt til at træne algoritmerne, mens de blev bygget.

AI-træningsdata er en grundlæggende proces i opbygningen machine learning og AI-algoritmer. Hvis du udvikler en app, der er baseret på disse teknologikoncepter, skal du træne dine systemer til at forstå dataelementer til optimeret behandling. Uden træning vil din AI-model være ineffektiv, mangelfuld og potentielt meningsløs.

Det anslås, at dataforskere bruger mere end 80% af deres tid i Dataforberedelse og berigelse for at træne ML -modeller.

Så for dem af jer, der ønsker at få finansiering fra venturekapitalister, soloprenørerne derude, der arbejder på ambitiøse projekter og techentusiaster, der lige er begyndt med avanceret AI, har vi udviklet denne vejledning til at besvare de vigtigste spørgsmål vedr. dine AI -træningsdata.

Her vil vi undersøge, hvad AI -træningsdata er, hvorfor er det uundgåeligt i din proces, mængden og kvaliteten af data, du rent faktisk har brug for og mere.

Hvad er AI-træningsdata?

AI-træningsdata er omhyggeligt sammensat og renset information, der føres ind i et system til træningsformål. Denne proces gør eller bryder en AI-models succes. Det kan hjælpe med at udvikle forståelsen af, at ikke alle firbenede dyr på et billede er hunde, eller det kan hjælpe en model med at skelne mellem vred råben og glædelig latter. Det er det første trin i opbygningen af kunstig intelligens-moduler, der kræver ske-fodring af data for at lære maskinerne det grundlæggende og sætte dem i stand til at lære, efterhånden som flere data fødes. Dette giver igen plads til et effektivt modul, der udsender præcise resultater til slutbrugerne.

Overvej en AI-træningsdataproces som en træningssession for en musiker, hvor jo mere de øver sig, jo bedre bliver de til en sang eller en skala. Den eneste forskel her er, at maskiner også først skal læres, hvad et musikinstrument er. I lighed med musikeren, der gør god brug af de utallige timer, der bruges på at øve på scenen, tilbyder en AI-model en optimal oplevelse for forbrugerne, når den er implementeret.

Hvorfor kræves AI-træningsdata?

Det enkleste svar på, hvorfor AI-træningsdata er påkrævet for en models udvikling, er at uden det ville maskiner ikke engang vide, hvad de skulle forstå i første omgang. Ligesom en person, der er trænet til deres særlige job, har en maskine brug for et informationscorpus for at tjene et specifikt formål og levere tilsvarende resultater.

Lad os overveje eksemplet på autonome biler igen. Terabyte efter terabyte data i et selvkørende køretøj kommer fra flere sensorer, computersynsenheder, RADAR, LIDAR'er og meget mere. Alle disse massive klumper af data ville være meningsløse, hvis bilens centrale behandlingssystem ikke ved, hvad de skal gøre med det.

For eksempel er den computersyn Enheden i bilen kunne spytte mængder af data om vejelementer som fodgængere, dyr, potholes og mere. Hvis maskinlæringsmodulet ikke er uddannet til at identificere dem, ved køretøjet ikke, at det er forhindringer, der kan forårsage ulykker, hvis de opstår. Derfor skal modulerne trænes i, hvad hvert eneste element på vejen er, og hvordan forskellige kørselsbeslutninger er nødvendige for hver enkelt.

Mens dette kun er til visuelle elementer, skal bilen også være i stand til at forstå menneskelige instruktioner igennem Natural Language Processing (NLP) , lyd- eller taleindsamling og svar i overensstemmelse hermed. For eksempel, hvis føreren befaler infotainment-systemet i bilen til at lede efter tankstationer i nærheden, skal den være i stand til at forstå kravet og kaste passende resultater. Til det skal det dog være i stand til at forstå hvert eneste ord i sætningen, forbinde dem og være i stand til at forstå spørgsmålet.

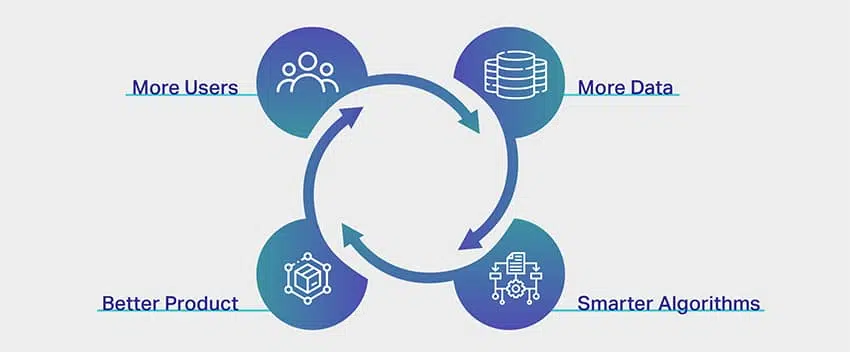

Mens du måske spekulerer på, om processen med AI-træningsdata kun er kompleks, fordi den bruges til en tung brugssag som en autonom bil, er faktum, at selv den næste film, som Netflix anbefaler, gennemgår den samme proces for at tilbyde dig personlige forslag. Enhver app, platform eller en enhed, der har AI tilknyttet, drives som standard af AI-træningsdata.

Hvilke typer data har jeg brug for?

Der er 4 primære datatyper, der ville være nødvendige, dvs. billede, video, lyd/tale eller tekst for effektivt at kunne træne modeller for maskinlæring. Den type data, der er nødvendig, vil afhænge af en række forskellige faktorer, såsom den aktuelle case case, kompleksiteten af modeller, der skal trænes, den træningsmetode, der anvendes, og mangfoldigheden af inputdata, der kræves.

Hvor meget data er tilstrækkelige?

De siger, at der ikke er nogen ende på læring, og denne sætning er ideel i AI-træningsdataspektret. Jo flere data, jo bedre resultater. Et svar så vagt som dette er imidlertid ikke nok til at overbevise alle, der ønsker at starte en AI-drevet app. Men virkeligheden er, at der ikke er nogen generel tommelfingerregel, en formel, et indeks eller en måling af det nøjagtige datamængde, man har brug for for at træne deres AI-datasæt.

En maskineindlæringsekspert vil komisk afsløre, at der skal bygges en separat algoritme eller et modul for at udlede den datamængde, der kræves til et projekt. Desværre er det også virkeligheden.

Nu er der en grund til, at det er ekstremt vanskeligt at sætte et loft på den mængde data, der kræves til AI-træning. Dette er på grund af kompleksiteten involveret i selve træningsprocessen. Et AI-modul består af flere lag af sammenkoblede og overlappende fragmenter, der påvirker og supplerer hinandens processer.

Lad os for eksempel overveje, at du udvikler en simpel app til at genkende et kokosnøddetræ. Fra udsigten lyder det ret simpelt, ikke? Fra et AI-perspektiv er det dog meget mere komplekst.

Helt i starten er maskinen tom. Det ved ikke, hvad et træ er i første omgang endsige et højt, regionsspecifikt, tropisk frugtbærende træ. Til det skal modellen trænes i, hvad et træ er, hvordan man adskiller sig fra andre høje og slanke genstande, der kan forekomme i ramme som gadebelysning eller elektriske poler og derefter gå videre for at lære det nuancerne i et kokosnødtræ. Når maskinlæringsmodulet har lært, hvad et kokosnødtræ er, kunne man roligt antage, at det ved, hvordan man genkender et.

Men kun når du fodrer et billede af et banyantræ, ville du indse, at systemet har fejlagtigt identificeret et banyantræ for et kokosnødtræ. For et system er alt, der er højt med klynget løv, et kokosnødtræ. For at fjerne dette skal systemet nu forstå hvert eneste træ, der ikke er et kokosnødtræ, for at identificere præcist. Hvis dette er processen til en simpel envejs -app med kun ét resultat, kan vi kun forestille os kompleksiteten i apps, der er udviklet til sundhedspleje, økonomi og mere.

Bortset fra dette, hvad påvirker også mængden af data, der kræves til uddannelse inkluderer aspekter, der er anført nedenfor:

- Træningsmetode, hvor forskellene i datatyper (struktureret og ustrukturerede) påvirker behovet for datamængder

- Datamærkning eller annotationsteknikker

- Måden, hvorpå data føres til et system

- Fejltolerance kvotient, hvilket simpelthen betyder procentdelen af fejl, der er ubetydelige i din niche eller dit domæne

Virkelige eksempler på træningsvolumener

Selvom mængden af data, du har brug for til at træne dine moduler, afhænger på dit projekt og de andre faktorer, vi diskuterede tidligere, lidt inspiration eller reference ville hjælpe med at få en omfattende idé om data krav.

Følgende er eksempler på den virkelige verden af antallet af anvendte datasæt til AI-træningsformål af forskellige virksomheder og virksomheder.

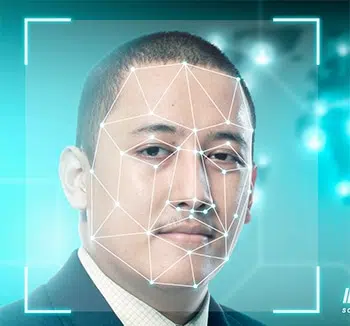

- Ansigtsgenkendelse - en stikprøvestørrelse på over 450,000 ansigtsbilleder

- Billedkommentar - en stikprøvestørrelse på over 185,000 billeder med tæt på 650,000 kommenterede objekter

- Facebook-sentimentanalyse - en stikprøvestørrelse på over 9,000 kommentarer og 62,000 indlæg

- Chatbot træning - en stikprøvestørrelse på over 200,000 spørgsmål med over 2 millioner svar

- Oversættelsesapp - en stikprøvestørrelse på over 300,000 lyd eller tale samling fra ikke-indfødte højttalere

Hvad hvis jeg ikke har nok data?

I AI & ML -verdenen er datatræning uundgåelig. Det siges med rette, at der ikke er nogen ende på at lære nye ting, og det gælder, når vi taler om AI -træningsdataspektret. Jo flere data, jo bedre resultater. Der er dog tilfælde, hvor den use case, du forsøger at løse, vedrører en nichekategori, og det er en udfordring at skaffe det rigtige datasæt i sig selv. Så i dette scenario, hvis du ikke har tilstrækkelige data, er forudsigelserne fra ML -modellen muligvis ikke nøjagtige eller kan være forudindtaget. Der er måder såsom dataforøgelse og datamarkering, der kan hjælpe dig med at overvinde manglerne, men resultatet er muligvis stadig ikke nøjagtigt eller pålideligt.

Hvordan forbedrer du datakvaliteten?

Datakvaliteten er direkte proportional med outputkvaliteten. Derfor kræver meget nøjagtige modeller datasæt af høj kvalitet til træning. Der er dog en fangst. For et koncept, der er afhængigt af præcision og nøjagtighed, er begrebet kvalitet ofte temmelig vagt.

Højkvalitetsdata lyder stærkt og troværdigt, men hvad betyder det egentlig?

Hvad er kvalitet i første omgang?

Nå, ligesom netop de data, vi leverer i vores systemer, har kvalitet også mange faktorer og parametre forbundet med det. Hvis du når ud til AI-eksperter eller maskinindlæringsveteraner, deler de muligvis enhver permutation af data af høj kvalitet er alt hvad der er -

- Uniform - data, der kommer fra en bestemt kilde eller ensartethed i datasæt, der kommer fra flere kilder

- Omfattende - data, der dækker alle mulige scenarier, som dit system er beregnet til at arbejde på

- Konsekvent - hver eneste data-byte har samme karakter

- Relevant - de data, du kilder og fodrer, svarer til dine krav og forventede resultater og

- diverse - du har en kombination af alle typer data såsom lyd, video, billede, tekst og mere

Nu hvor vi forstår, hvad kvalitet i datakvalitet betyder, lad os hurtigt se på de forskellige måder, vi kan sikre kvalitet på dataindsamling og generation.

1. Hold øje med strukturerede og ustrukturerede data. Førstnævnte er let forståelig for maskiner, fordi de har kommenterede elementer og metadata. Sidstnævnte er imidlertid stadig rå uden værdifuld information et system kan gøre brug af. Det er her dataanmelding kommer ind.

2. Eliminering af bias er en anden måde at sikre kvalitetsdata på, da systemet fjerner eventuelle fordomme fra systemet og leverer et objektivt resultat. Bias forvrænger kun dine resultater og gør det forgæves.

3. Rengør data grundigt, da dette altid vil øge kvaliteten af dine output. Enhver datavidenskabsmand ville fortælle dig, at en stor del af deres jobrolle er at rense data. Når du renser dine data, fjerner du dubletter, støj, manglende værdier, strukturelle fejl osv.

Hvad påvirker uddannelseskvaliteten?

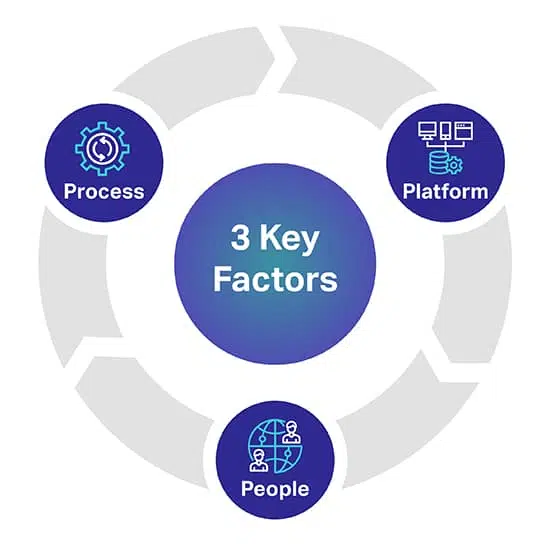

Der er tre hovedfaktorer, der kan hjælpe dig med at forudsige det kvalitetsniveau, du ønsker for dine AI/ML -modeller. De 3 nøglefaktorer er People, Process og Platform, der kan lave eller bryde dit AI -projekt.

Platform: En komplet human-in-the-loop proprietær platform er påkrævet for at kilde, transskribere og kommentere forskellige datasæt for at kunne implementere de mest krævende AI- og ML-initiativer. Platformen er også ansvarlig for at styre medarbejdere og maksimere kvalitet og gennemstrømning

Mennesker: At få AI til at tænke smartere kræver mennesker, der er nogle af de klogeste sind i branchen. For at skalere skal du bruge tusinder af disse fagfolk over hele verden til at transskribere, mærke og kommentere alle datatyper.

Proces: At levere guldstandarddata, der er konsistente, komplette og præcise, er komplekst arbejde. Men det er hvad du altid skal levere for at overholde de højeste kvalitetsstandarder samt strenge og dokumenterede kvalitetskontroller og kontrolpunkter.

Hvor henter du AI-træningsdata fra?

I modsætning til vores tidligere afsnit har vi en meget præcis indsigt her. For dem af jer, der ønsker at kildedata

eller hvis du er i gang med videosamling, billedsamling, tekstsamling og mere, er der tre

primære veje, du kan kilde dine data fra.

Lad os udforske dem individuelt.

Gratis kilder

Gratis kilder er veje, der er ufrivillige opbevaringssteder for enorme datamængder. Det er data, der simpelthen ligger der på overfladen gratis. Nogle af de gratis ressourcer inkluderer -

- Google datasæt, hvor der blev frigivet over 250 millioner datasæt i 2020

- Fora som Reddit, Quora og mere, som er ressourcefulde kilder til data. Desuden kan datalogi og AI-samfund i disse fora også hjælpe dig med bestemte datasæt, når du når ud til dem.

- Kaggle er en anden gratis kilde, hvor du kan finde maskinlæringsressourcer bortset fra gratis datasæt.

- Vi har også angivet gratis åbne datasæt for at komme i gang med at træne dine AI-modeller

Mens disse veje er gratis, er det tid og kræfter, hvad du ender med at bruge. Data fra gratis kilder er overalt, og du er nødt til at lægge timers arbejde i sourcing, rengøring og skræddersy det, så det passer til dine behov.

En af de andre vigtige pointer at huske er, at nogle af dataene fra gratis kilder ikke kan bruges til kommercielle formål. Det kræver datalicensering.

Dataskrapning

Som navnet antyder, er dataskrabning processen med minedrift af data fra flere kilder ved hjælp af passende værktøjer. Fra websteder, offentlige portaler, profiler, tidsskrifter, dokumenter og mere kan værktøjer skrabe data, du har brug for, og få dem problemfrit til din database.

Selvom dette lyder som en ideel løsning, er dataskrabning kun lovligt, når det kommer til personlig brug. Hvis du er en virksomhed, der ønsker at skrabe data med kommercielle ambitioner involveret, bliver det vanskeligt og endda ulovligt. Derfor har du brug for et juridisk team til at undersøge websteder, overholdelse og betingelser, før du kan skrabe data, du har brug for.

Eksterne leverandører

For så vidt angår dataindsamling til AI-træningsdata er outsourcing eller kontakt til eksterne leverandører til datasæt den mest ideelle mulighed. De tager ansvaret for at finde datasæt til dine krav, mens du kan fokusere på at opbygge dine moduler. Dette skyldes specifikt følgende årsager -

- du behøver ikke bruge timer på at lede efter dataveje

- der er ingen bestræbelser med hensyn til datarensning og klassificering involveret

- du får i hånd kvalitetsdatasæt, der præcist afkrydser alle de faktorer, vi diskuterede for nogen tid tilbage

- du kan få datasæt, der er skræddersyet til dine behov

- du kan kræve den mængde data, du har brug for til dit projekt og mere

- og det vigtigste sikrer de også, at deres dataindsamling og selve dataene overholder lokale lovgivningsmæssige retningslinjer.

Den eneste faktor, der kan vise sig at være en mangel afhængigt af din operationelle skala, er at outsourcing involverer udgifter. Igen, hvad der ikke indebærer udgifter.

Shaip er allerede førende inden for dataindsamlingstjenester og har sit eget lager af sundhedsdata og tale- / lyddatasæt, der kan licenseres til dine ambitiøse AI-projekter.

Åbn datasæt - At bruge eller ikke at bruge?

For eksempel er der Amazon-produktdatasættet, der indeholder over 142 millioner brugeranmeldelser fra 1996 til 2014. For billeder har du en fremragende ressource som Google Open Images, hvor du kan kilde datasæt fra over 9 millioner billeder. Google har også en fløj kaldet Machine Perception, der tilbyder næsten 2 millioner lydklip med en varighed på ti sekunder.

På trods af tilgængeligheden af disse ressourcer (og andre) er den vigtige faktor, der ofte overses, de betingelser, der følger med deres anvendelse. De er helt sikkert offentlige, men der er en tynd linje mellem overtrædelse og fair brug. Hver ressource har sin egen tilstand, og hvis du udforsker disse muligheder, foreslår vi forsigtighed. Dette skyldes, at du med påskud af at foretrække gratis veje kan ende med at afholde retssager og allierede udgifter.

De sande omkostninger ved AI-træningsdata

Kun de penge, du bruger på at skaffe data eller generere data internt, er ikke det, du bør overveje. Vi skal overveje lineære elementer som tid og indsats brugt på at udvikle AI-systemer og koste fra et transaktionsperspektiv. undlader at komplimentere den anden.

Tid brugt på sourcing og annotering af data

Faktorer som geografi, markedsdemografi og konkurrence inden for din niche hindrer tilgængeligheden af relevante datasæt. Den tid, der bruges manuelt til at søge efter data, er tidsspildende i uddannelse af dit AI-system. Når du har formået at kilde dine data, vil du yderligere forsinke uddannelsen ved at bruge tid på at kommentere dataene, så din maskine kan forstå, hvad den bliver fodret med.

Prisen for indsamling og kommentering af data

Overheadudgifter (interne dataindsamlere, annotatorer, vedligeholdelsesudstyr, teknisk infrastruktur, abonnementer på SaaS-værktøjer, udvikling af proprietære applikationer) skal beregnes, mens AI-data hentes

Omkostningerne ved dårlige data

Dårlige data kan koste din virksomheds team moral, din konkurrencefordel og andre håndgribelige konsekvenser, der går ubemærket hen. Vi definerer dårlige data som ethvert datasæt, der er urent, råt, irrelevant, forældet, unøjagtigt eller fuldt af stavefejl. Dårlige data kan ødelægge din AI -model ved at introducere bias og ødelægge dine algoritmer med skæve resultater.

Ledelsesudgifter

Alle omkostninger i forbindelse med administrationen af din organisation eller virksomhed, materielle og immaterielle ting udgør administrationsomkostninger, som ofte er de dyreste.

Hvad næste efter datasourcing?

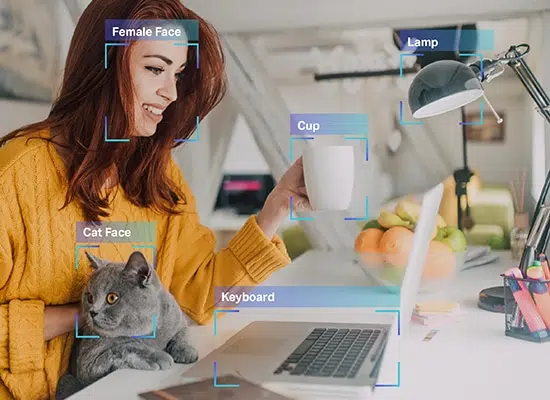

Når du har datasættet i din hånd, er det næste trin at kommentere eller mærke det. Efter alle de komplekse opgaver er, hvad du har, rene rådata. Maskinen kan stadig ikke forstå de data, du har, fordi de ikke er kommenteret. Det er her, den resterende del af den virkelige udfordring starter.

Som vi nævnte, har en maskine brug for data i et format, som den kan forstå. Dette er præcis, hvad datanotering gør. Det tager rådata og tilføjer lag af etiketter og tags for at hjælpe et modul med at forstå hvert enkelt element i dataene nøjagtigt.

For eksempel i en tekst fortæller datamærkning et AI-system den grammatiske syntaks, taledele, præpositioner, tegnsætning, følelser, følelser og andre parametre, der er involveret i maskinforståelse. Sådan forstår chatbots menneskelige samtaler bedre, og kun når de gør det, kan de også efterligne menneskelige interaktioner gennem deres svar.

Så uundgåeligt som det lyder, er det også ekstremt tidskrævende og kedeligt. Uanset omfanget af din virksomhed eller dens ambitioner er det enormt lang tid at tage kommentarer.

Dette skyldes primært, at din eksisterende arbejdsstyrke skal bruge tid ud af deres daglige tidsplan for at kommentere data, hvis du ikke har specialister i datakommentarer. Så du skal indkalde dine teammedlemmer og tildele dette som en ekstra opgave. Jo mere det bliver forsinket, jo længere tid tager det at træne dine AI -modeller.

Selvom der er gratis værktøjer til dataanmærkning, fjerner det ikke det faktum, at denne proces er tidskrævende.

Det er her, dataleverandører som Shaip kommer ind. De bringer et dedikeret team af dataannotationsspecialister med sig for kun at fokusere på dit projekt. De tilbyder dig løsninger på den måde, du ønsker til dine behov og krav. Desuden kan du indstille en tidsramme med dem og kræve, at arbejdet afsluttes i den specifikke tidslinje.

En af de største fordele er, at dine interne teammedlemmer kan fortsætte med at fokusere på det, der betyder mere for din drift og dit projekt, mens eksperter gør deres job med at kommentere og mærke data til dig.

Med outsourcing kan optimal kvalitet, minimal tid og maksimal præcision sikres.

Indpakning op

Det var alt om AI -træningsdata. Fra at forstå, hvad uddannelsesdata er til at udforske gratis ressourcer og fordele ved outsourcing af datakommentarer, diskuterede vi dem alle. Igen er protokoller og politikker stadig flak i dette spektrum, og vi anbefaler altid, at du kommer i kontakt med AI -træningsdataeksperter som os for dine behov.

Fra indkøb, afidentificering til datakommentarer hjælper vi dig med alle dine behov, så du kun kan arbejde på at bygge din platform. Vi forstår de finurligheder, der er involveret i dataindsamling og -mærkning. Derfor gentager vi, at du kunne overlade de svære opgaver til os og gøre brug af vores løsninger.

Henvend dig til os for alle dine behov for datakommentarer i dag.

Lad os tale

Ofte stillede spørgsmål (FAQ)

Hvis du vil oprette intelligente systemer, skal du indføre ren, kurateret og praktisk information for at lette overvåget læring. Den mærkede information betegnes AI -træningsdata og omfatter markedsmetadata, ML -algoritmer og alt, hvad der hjælper med beslutningstagning.

Hver AI-drevet maskine har kapaciteter begrænset af dens historiske standpunkt. Det betyder, at maskinen kun kan forudsige det ønskede resultat, hvis den tidligere er blevet trænet med sammenlignelige datasæt. Træningsdata hjælper med overvåget træning med volumen, der er direkte proportional med effektiviteten og nøjagtigheden af AI -modellerne.

Forskellige træningsdatasæt er nødvendige for at træne specifikke maskinlæringsalgoritmer for at hjælpe de AI-drevne opsætninger med at tage vigtige beslutninger med kontekster i tankerne. For eksempel, hvis du planlægger at tilføje Computer Vision -funktionalitet til en maskine, skal modellerne trænes med annoterede billeder og flere markedsdatasæt. Tilsvarende for NLP -dygtighed fungerer store mængder talesamling som træningsdata.

Der er ingen øvre grænse for mængden af træningsdata, der kræves for at træne en kompetent AI -model. Større datamængde bliver modellens evne til at identificere og adskille elementer, tekster og kontekster.

Selvom der er mange data til rådighed, er ikke alle dele velegnede til træningsmodeller. For at en algoritme kan fungere bedst, skal du have omfattende, konsekvente og relevante datasæt, der er ensartet udpakket, men stadig forskellige nok til at dække en lang række scenarier. Uanset de data, du planlægger at bruge, er det bedre at rense og kommentere det samme for forbedret læring.

Hvis du har en bestemt AI-model i tankerne, men træningsdataene ikke er helt nok, skal du først fjerne outliers, parre i overførsels- og iterative læringsopsætninger, begrænse funktionaliteter og gøre opsætningen open-source for brugerne at blive ved med at tilføje data for træner maskinen gradvist i tide. Du kan endda følge tilgange vedrørende dataforøgelse og overførselslæring for at få mest muligt ud af begrænsede datasæt.

Åbne datasæt kan altid bruges til at indsamle træningsdata. Men hvis du søger eksklusivitet til at træne modellerne bedre, kan du stole på eksterne leverandører, gratis kilder som Reddit, Kaggle og mere og endda dataskrapning til selektivt at minde indsigt fra profiler, portaler og dokumenter. Uanset tilgang er det nødvendigt at formatere, reducere og rense de indkøbte data før brug.