Hvis du udvikler en AI-løsning, afhænger time-to-market af dit produkt i høj grad af rettidig tilgængelighed af kvalitetsdatasæt til uddannelsesformål. Først når du har dine nødvendige datasæt i hånden, kan du starte dine modellers træningsprocesser, optimere resultater og få din løsning klar til lancering.

Og du ved, at hente kvalitetsdatasæt til tiden er en skræmmende udfordring for virksomheder i alle størrelser og skalaer. For de uindviede, tæt på 19% af virksomhederne afsløre, at det er den manglende tilgængelighed af data, der begrænser dem fra at vedtage AI -løsninger.

Vi bør også forstå, at selvom du formår at generere relevante og kontekstuelle data, dataarnnotering er en udfordring i sig selv. Det er tidskrævende og kræver fremragende beherskelse og opmærksomhed på detaljer. Omkring 80% af en AIs udviklingstid går på at kommentere datasæt.

Nu kan vi ikke bare helt fjerne data -annotationsprocesser fra vores systemer, da de er punktum for AI -uddannelse. Dine modeller ville undlade at levere resultater (endsige kvalitetsresultater), hvis der ikke er kommenterede data i hånden. Indtil videre har vi diskuteret et utal af emner om databaserede udfordringer, annoteringsteknikker og mere. I dag vil vi diskutere et andet afgørende aspekt, der kredser om selve datamærkning.

I dette indlæg vil vi undersøge de to typer af annotationsmetoder, der bruges på tværs af spektret, som er:

- Manuel datamærkning

- Og automatisk datamærkning

Vi vil belyse forskellene mellem de to, hvorfor manuel indgriben er nøglen, og hvilke risici der er forbundet med automatisk datamærkning.

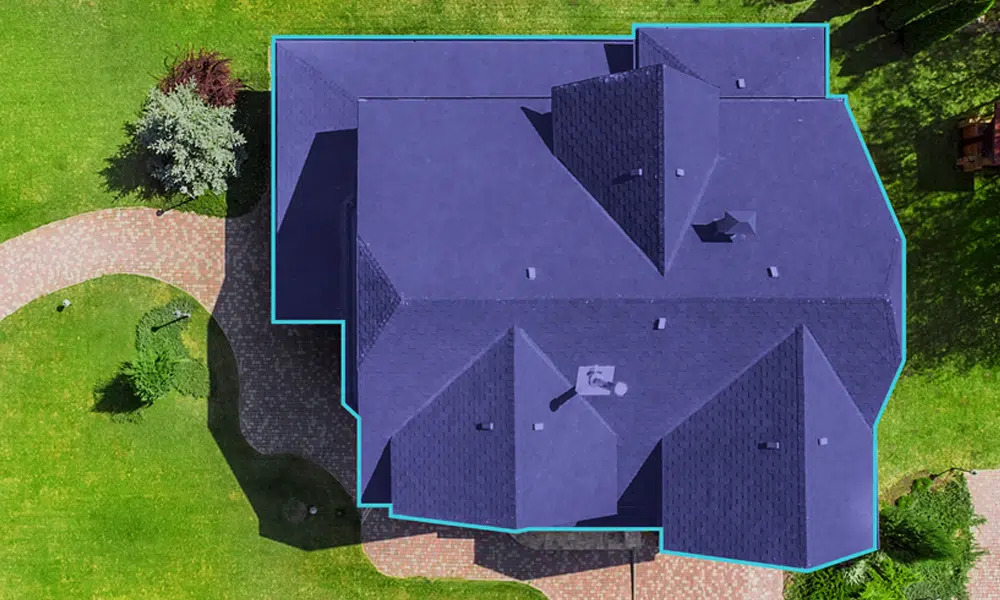

Manuel datamærkning

Som navnet antyder, involverer manuel datamærkning mennesker. Dataanmeldingseksperter tager ansvar for tagging -elementer i datasæt. Med eksperter mener vi SMV'er og domænemyndigheder, der præcist ved, hvad de skal kommentere. Den manuelle proces begynder med, at annotatorer forsynes med rå datasæt til annotering. Datasættene kan være billeder, videofiler, lydoptagelser eller transskriptioner, tekster eller en kombination af disse.

Baseret på projekter, krævede resultater og specifikationer arbejder annotatorer med at kommentere relevante elementer. Eksperter ved, hvilken teknik der er bedst egnet til specifikke datasæt og formål. De bruger den rigtige teknik til deres projekter og leverer træningsbare datasæt til tiden.

Mens manuel mærkning kun er en del af processen, er der en anden fase i annotationsarbejdsprocessen kaldet kvalitetskontrol og revision. I dette verificeres kommenterede datasæt for ægthed og præcision. For at gøre dette vedtager virksomheder en konsensusmetode, hvor flere annotationer arbejder på de samme datasæt for enstemmige resultater. Uoverensstemmelser løses også i tilfælde af kommentarer og markering. Sammenlignet med annotationsprocessen er kvalitetskontrolfasen mindre anstrengende og tidskrævende.

Automatisk datamærkning

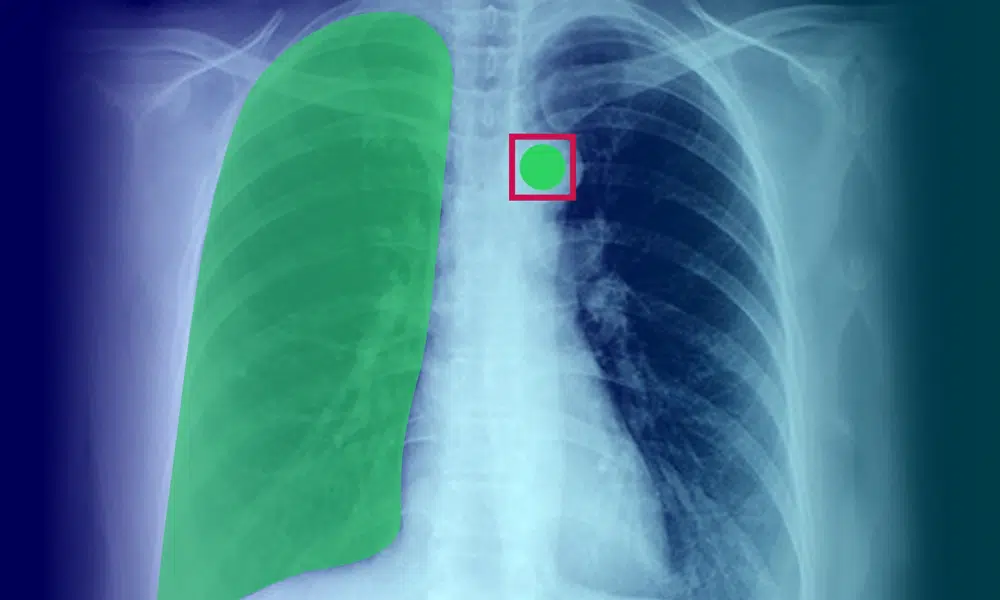

Så nu forstår du, hvor meget manuel indsats der går til datamærkning. For at løsninger, der skal bruges i sektorer som sundhedspleje, bliver præcision og opmærksomhed på detaljer endnu mere afgørende. For at bane vejen for hurtigere datamærkning og levering af kommenterede data, bliver automatiske datamærkningsmodeller gradvist fremtrædende.

I denne metode tager AI -systemer sig af annotering af data. Dette opnås ved hjælp af enten heuristiske metoder eller maskinlæringsmodeller eller begge dele. I den heuristiske metode sendes et enkelt datasæt gennem en række foruddefinerede regler eller betingelser for at validere en bestemt etiket. Betingelserne er fastsat af mennesker.

Selvom dette er effektivt, mislykkes denne metode, når datastrukturer ofte ændres. Det bliver også komplekst at fastlægge betingelser for at få systemer til at træffe en informeret beslutning. Mens mennesker kan skelne mellem is og limonade, kender vi ikke den tilgang, hjernen tager for at komme frem til sondringen. At kopiere dette er menneskeligt umuligt i maskiner.

Dette giver anledning til en række bekymringer med hensyn til kvaliteten af resultaterne fra AI -systemer. På trods af at automatisering starter, har du brug for et menneske (eller en flok af dem) til at validere og rette datatiketter. Og dette er et glimrende segment til vores næste afsnit.

AI-assisteret annotering: Intelligens kræver hjerner (hybrid tilgang)

For de bedste resultater kræves en hybrid tilgang. Mens AI -systemer kan tage sig af hurtigere mærkning, kan mennesker validere resultater og optimere dem. Det kan være en dårlig idé at overlade hele processen med datakommentarer til maskiner.

Der er en balance, der er etableret, og processen kan også ske på omkostningseffektive måder. Eksperter kan komme med optimerede feedback -sløjfer til maskiner til at slippe bedre etiketter, hvilket i sidste ende reducerer behovet for involverede manuelle indsatser. Med den betydelige stigning i maskintillidsscorer kan kvaliteten af mærkede data også forbedres.

Indpakning op

Helt autonom datamærkning mekanismer ville aldrig fungere - i hvert fald for nu. Det, vi kræver, er harmoni mellem menneske og maskiner i udførelsen af en kedelig opgave. Dette øger også leveringstiden for kommenterede datasæt, hvor virksomheder problemfrit kan starte deres AI -træningsfaser. Og hvis du leder efter datasæt af høj kvalitet til dine AI-modeller, kontakt os i dag.