En begyndervejledning til AI-dataindsamling

Valg af AI Data Collection Company til dit AI / ML-projekt

Introduktion

Lige nu træder vi på den rigtige vej med betydelige gennembrud, der sker på tværs af brancher ved hjælp af kunstig intelligens. Hvis du for eksempel tager sundhedspleje, hjælper AI-systemer ledsaget af maskinlæringsmodeller eksperter med at forstå kræft bedre og komme med behandlinger for det. Neurologiske lidelser og bekymringer som PTSD bliver behandlet ved hjælp af AI. Vacciner udvikles med høje hastigheder takket være AI-drevne kliniske forsøg og simuleringer.

Ikke kun sundhedsvæsenet, hver eneste branche eller segment, som AI berører, bliver revolutioneret. Autonome køretøjer, smarte dagligvarebutikker, wearables som FitBit og endda vores smartphone-kameraer er i stand til at tage bedre billeder af vores ansigter med AI.

Takket være de innovationer, der sker i AI-området, vælter virksomheder ind i spektret med forskellige use cases og løsninger. På grund af dette forventes det globale AI-marked at nå en markedsværdi på omkring $267 mia. ved udgangen af 2027. Desuden implementerer omkring 37 % af virksomhederne derude allerede AI-løsninger i deres processer og produkter.

Mere interessant er det, at tæt på 77 % af de produkter og tjenester, vi bruger i dag, er drevet af kunstig intelligens. Med teknologikonceptet stigende markant på tværs af vertikaler, hvordan formår virksomheder at gøre det umuligt med AI?

Hvordan får chatbots os til at tro, at vi taler med et andet menneske på den anden side?

Hvis du observerer svaret på hvert spørgsmål, koger det ned til kun ét element – DATA. Data er i centrum for alle AI-specifikke operationer og processer. Det er data, der hjælper maskiner med at forstå koncepter, procesinput og levere præcise resultater.

Alle de store AI-løsninger, der findes, er alle produkter af en afgørende proces, vi kalder dataindsamling eller dataindsamling eller AI-træningsdata.

Denne omfattende guide handler om at hjælpe dig med at forstå, hvad det er, og hvorfor det er vigtigt.

Hvad er AI-dataindsamling?

Maskiner har ikke deres eget sind. Fraværet af dette abstrakte koncept gør dem blottet for meninger, fakta og evner såsom ræsonnement, erkendelse og mere. De er bare faste kasser eller enheder, der optager plads. For at gøre dem til kraftfulde medier har du brug for algoritmer og endnu vigtigere data.

Hvert eneste AI-aktiverede produkt eller løsning, vi bruger i dag, og de resultater, de tilbyder, stammer fra mange års træning, udvikling og optimering. Fra enheder, der tilbyder navigationsruter til de komplekse systemer, der forudsiger udstyrsfejl dage i forvejen, har hver enkelt enhed gennemgået mange års AI-træning for at kunne levere præcise resultater.

AI-dataindsamling er det indledende trin i processen med AI-udvikling, der lige fra begyndelsen bestemmer, hvor effektivt et AI-system ville være. Det er processen med at hente relevante datasæt fra et utal af kilder, der vil hjælpe AI-modeller med at behandle detaljer bedre og give meningsfulde resultater.

Typer af AI-træningsdata i maskinlæring

Nu er AI-dataindsamling et paraplybegreb. Data i dette rum kan betyde hvad som helst. Det kan være tekst, videooptagelser, billeder, lyd eller en blanding af alle disse. Kort sagt, alt, hvad der er nyttigt for en maskine til at udføre sin opgave med at lære og optimere resultater, er data. For at give dig mere indsigt i de forskellige typer data, er her en hurtig liste:

Datasæt kan være fra en struktureret eller ustruktureret kilde. For de uindviede er strukturerede datasæt dem, der har eksplicit betydning og format. De er let forståelige for maskiner. Ustruktureret er på den anden side detaljer i datasæt, der er overalt. De følger ikke en bestemt struktur eller et bestemt format og kræver menneskelig indgriben for at trække værdifuld indsigt ud fra sådanne datasæt.

Tekstdata

En af de mest udbredte og fremtrædende former for data. Tekstdata kunne struktureres i form af indsigt fra databaser, GPS-navigationsenheder, regneark, medicinsk udstyr, formularer og mere. Ustruktureret tekst kan være undersøgelser, håndskrevne dokumenter, billeder af tekst, e-mail-svar, kommentarer på sociale medier og mere.

Lyddata

Lyddatasæt hjælper virksomheder med at udvikle bedre chatbots og systemer, designe bedre virtuelle assistenter og mere. De hjælper også maskiner med at forstå accenter og udtale af de forskellige måder, et enkelt spørgsmål eller forespørgsel kan stilles på.

Billeddata

Billeder er en anden fremtrædende datasættype, der bruges til forskellige formål. Fra selvkørende biler og applikationer som Google Lens til ansigtsgenkendelse hjælper billeder systemer med at finde problemfrie løsninger.

Video data

Videoer er mere detaljerede datasæt, der lader maskiner forstå noget i dybden. Videodatasæt er hentet fra computervision, digital billedbehandling og mere.

Hvordan indsamler man data til en maskinlæring?

Så hvordan henter du dine data? Hvilke data har du brug for, og hvor meget af dem? Hvad er de mange kilder til at hente relevante data?

Virksomheder vurderer nichen og formålet med deres ML-modeller og kortlægger potentielle måder at hente relevante datasæt på. At definere den nødvendige datatype løser en stor del af din bekymring om datakilde. For at give dig en bedre idé er der forskellige kanaler, veje, kilder eller medier til dataindsamling:

Gratis kilder

Som navnet antyder, er disse ressourcer, der tilbyder datasæt til AI-træningsformål gratis. Gratis kilder kan være alt lige fra offentlige fora, søgemaskiner, databaser og mapper til offentlige portaler, der vedligeholder arkiver med information gennem årene.

Hvis du ikke ønsker at lægge for mange kræfter i at hente gratis datasæt, findes der dedikerede websteder og portaler som Kaggle, AWS-ressource, UCI-database og mere, der giver dig mulighed for at udforske forskellige

kategorier og download nødvendige datasæt gratis.

Interne ressourcer

Selvom gratis ressourcer ser ud til at være praktiske muligheder, er der flere begrænsninger forbundet med dem. For det første kan du ikke altid være sikker på, at du vil finde datasæt, der præcist matcher dine krav. Selvom de matcher, kan datasæt være irrelevante med hensyn til tidslinjer.

Hvis dit markedssegment er relativt nyt eller uudforsket, ville der ikke være mange kategorier eller relevante

datasæt, som du også kan downloade. For at undgå de foreløbige mangler med gratis ressourcer, der

eksisterer en anden dataressource, der fungerer som en kanal for dig til at generere mere relevante og kontekstuelle datasæt.

De er dine interne kilder såsom CRM-databaser, formularer, e-mail-marketing-leads, produkt- eller servicedefinerede touchpoints, brugerdata, data fra bærbare enheder, websitedata, varmekort, indsigt i sociale medier og mere. Disse interne ressourcer defineres, konfigureres og vedligeholdes af dig. Så du kan være sikker på dens troværdighed, relevans og seneste.

Betalte ressourcer

Uanset hvor nyttige de lyder, har interne ressourcer også deres rimelige andel af komplikationer og begrænsninger. For eksempel vil det meste af fokus i din talentpulje gå til at optimere datakontaktpunkter. Desuden skal koordineringen mellem dine teams og ressourcer også være upåklagelig.

For at undgå flere sådanne hikke som disse, har du betalte kilder. De er tjenester, der tilbyder dig de mest nyttige og kontekstuelle datasæt til dine projekter og sikrer, at du konsekvent får dem, når du har brug for det.

Det første indtryk, de fleste af os har på betalte kilder eller dataleverandører, er, at de er dyre. Imidlertid,

når du regner, er de kun billige i det lange løb. Takket være deres ekspansive netværk og data sourcing-metoder vil du være i stand til at modtage komplekse datasæt til dine AI-projekter, uanset hvor usandsynlige de er.

For at give dig en detaljeret oversigt over forskellene mellem de tre kilder, er her en udførlig tabel:

| Gratis ressourcer | Interne ressourcer | Betalte ressourcer |

|---|---|---|

| Datasæt er gratis tilgængelige. | Interne ressourcer kan også være gratis afhængigt af dine driftsudgifter. | Du betaler en dataleverandør for at hente relevante datasæt til dig. |

| Flere gratis ressourcer tilgængelige online for at downloade foretrukne datasæt. | Du får specialdefinerede data i henhold til dine behov for AI-træning. | Du får tilpasset definerede data konsekvent, så længe du har brug for det. |

| Du skal arbejde manuelt med at kompilere, kuratere, formatere og kommentere datasæt. | Du kan endda ændre dine databerøringspunkter for at generere datasæt med påkrævet information. | Datasæt fra leverandører er klar til maskinlæring. Det betyder, at de er kommenteret og leveres med kvalitetssikring. |

| Vær forsigtig med licens- og overholdelsesbegrænsninger på datasæt, du downloader. | Interne ressourcer bliver risikable, hvis du har en begrænset tid til at markedsføre dit produkt. | Du kan definere dine deadlines og få datasæt leveret i overensstemmelse hermed. |

Hvordan påvirker dårlige data dine AI -ambitioner?

Vi har listet de tre mest almindelige dataressourcer ud af den grund, at du vil have en idé om, hvordan du kan gribe dataindsamling og sourcing an. Men på dette tidspunkt bliver det vigtigt også at forstå, at din beslutning uvægerligt kan afgøre skæbnen for din AI-løsning.

I lighed med hvordan AI-træningsdata af høj kvalitet kan hjælpe din model med at levere nøjagtige og rettidige resultater, kan dårlige træningsdata også bryde dine AI-modeller, skævvrige resultater, introducere bias og give andre uønskede konsekvenser.

Men hvorfor sker dette? Er det ikke meningen, at nogen data skal træne og optimere din AI-model? Helt ærligt, nej. Lad os forstå dette nærmere.

Dårlige data – hvad er det?

Forskellen mellem ustrukturerede og dårlige data er, at indsigt i ustrukturerede data er overalt. Men i bund og grund kunne de være nyttige uanset. Ved at bruge ekstra tid vil dataforskere stadig være i stand til at udtrække relevant information fra ustrukturerede datasæt. Det er dog ikke tilfældet med dårlige data. Disse datasæt indeholder ingen/begrænset indsigt eller information, der er værdifuld eller relevant for dit AI-projekt eller dets træningsformål.

Så når du henter dine datasæt fra gratis ressourcer eller har løst etablerede interne datakontaktpunkter, er der stor sandsynlighed for, at du vil downloade eller generere dårlige data. Når dine videnskabsmænd arbejder på dårlige data, spilder du ikke kun menneskelige timer, men presser også lanceringen af dit produkt.

Hvis du stadig er i tvivl om, hvad dårlige data kan gøre ved dine ambitioner, er her en hurtig liste:

- Du bruger utallige timer på at skaffe de dårlige data og spilder timer, kræfter og penge på ressourcer.

- Dårlige data kan give dig juridiske problemer, hvis de ikke bliver bemærket, og kan nedsætte effektiviteten af din AI

modeller. - Når du tager dit produkt oplært på dårlig data live, påvirker det brugeroplevelsen

- Dårlige data kan gøre resultater og slutninger partiske, hvilket kan give yderligere tilbageslag.

Så hvis du spekulerer på, om der er en løsning på dette, er der faktisk.

AI Training Dataudbydere til undsætning

Alt du skal gøre er at tage dataene ind og træne dine AI-modeller til perfektion. Når det er sagt, er vi sikre på, at dit næste spørgsmål handler om omkostningerne forbundet med at samarbejde med dataleverandører. Vi forstår, at nogle af jer allerede arbejder på et mentalt budget, og det er præcis der, vi er på vej hen næste gang.

Faktorer, du skal overveje, når du skal opstille et effektivt budget for dit dataindsamlingsprojekt

AI-træning er en systematisk tilgang, og det er derfor, budgettering bliver en integreret del af det. Faktorer som RoI, nøjagtighed af resultater, træningsmetoder og mere bør overvejes, før du investerer en enorm mængde penge i AI-udvikling. Mange projektledere eller virksomhedsejere fumler på dette stadium. De træffer forhastede beslutninger, der medfører irreversible ændringer i deres produktudviklingsproces, hvilket i sidste ende tvinger dem til at bruge mere.

Dette afsnit vil dog give dig den rigtige indsigt. Når du sætter dig ned for at arbejde på budgettet for AI-træning, er tre ting eller faktorer uundgåelige.

Lad os se på hver enkelt i detaljer.

Mængden af data, du har brug for

Vi har hele tiden sagt, at effektiviteten og nøjagtigheden af din AI-model afhænger af, hvor meget den er trænet. Det betyder, at jo mere mængden af datasæt, jo mere læring. Men dette er meget vagt. For at sætte et tal på dette begreb offentliggjorde Dimensional Research en rapport, der afslørede, at virksomheder har brug for mindst 100,000 prøvedatasæt for at træne deres AI-modeller.

Med 100,000 datasæt mener vi 100,000 kvalitets- og relevante datasæt. Disse datasæt bør have alle de væsentlige attributter, annoteringer og indsigter, der kræves for, at dine algoritmer og maskinlæringsmodeller kan behandle information og udføre tilsigtede opgaver.

Med dette er en generel tommelfingerregel, lad os yderligere forstå, at mængden af data, du har brug for, også afhænger af en anden indviklet faktor, som er din virksomheds use case. Hvad du har tænkt dig at gøre med dit produkt eller din løsning afgør også, hvor meget data du har brug for. For eksempel ville en virksomhed, der bygger en anbefalingsmotor, have andre datavolumenkrav end en virksomhed, der bygger en chatbot.

Dataprisstrategi

Når du er færdig med at færdiggøre, hvor meget data du faktisk har brug for, skal du næste gang arbejde på en dataprisstrategi. Dette betyder i enkle vendinger, hvordan du ville betale for de datasæt, du anskaffer eller genererer.

Generelt er disse de konventionelle prisstrategier, der følges på markedet:

| Datatype | Prissætningsstrategi |

|---|---|

| Pris pr. Enkelt billedfil | |

| Prissat pr. Sekund, minut, en time eller individuel ramme | |

| Prisen pr. Sekund, et minut eller en time | |

| Pris pr. Ord eller sætning |

Men vent. Dette er igen en tommelfingerregel. De faktiske omkostninger ved at anskaffe datasæt afhænger også af faktorer som:

- Det unikke markedssegment, demografi eller geografi, hvorfra datasæt skal hentes

- Det indviklede i din use case

- Hvor meget data har du brug for?

- Din tid til at markedsføre

- Eventuelle skræddersyede krav og mere

Hvis du observerer, vil du vide, at omkostningerne ved at erhverve store mængder af billeder til dit AI-projekt kan være mindre, men hvis du har for mange specifikationer, kan priserne stige.

Dine indkøbsstrategier

Det her er tricky. Som du så, er der forskellige måder at generere eller hente data til dine AI-modeller på. Sund fornuft ville diktere, at gratis ressourcer er de bedste, da du kan downloade nødvendige mængder af datasæt gratis uden nogen komplikationer.

Lige nu ser det også ud til, at betalte kilder er for dyre. Men det er her, et lag af komplikationer bliver tilføjet. Når du henter datasæt fra gratis ressourcer, bruger du en ekstra mængde tid og kræfter på at rense dine datasæt, kompilere dem i dit virksomhedsspecifikke format og derefter kommentere dem individuelt. Du afholder driftsomkostninger i processen.

Med betalte kilder er betalingen engangsbetaling, og du får også maskinklare datasæt i hånden på det tidspunkt, du har brug for. Omkostningseffektiviteten er meget subjektiv her. Hvis du føler, at du har råd til at bruge tid på at kommentere gratis datasæt, kan du budgettere i overensstemmelse hermed. Og hvis du mener, at din konkurrence er hård og med begrænset tid til markedet, kan du skabe en ringvirkning på markedet, du bør foretrække betalte kilder.

Budgettering handler om at nedbryde detaljerne og klart definere hvert fragment. Disse tre faktorer bør tjene dig som en køreplan for din AI-træningsbudgetproces i fremtiden.

Sparer du på udgifterne med intern dataindsamling?

Vi ved, at du stadig er tøvende med hensyn til betalte kilder, og det er derfor, dette afsnit vil fjerne din skepsis over for det og kaste lys over de skjulte omkostninger, der er forbundet med intern datagenerering.

Er intern dataindsamling dyrt?

Ja det er!

Nu, her er et udførligt svar. Udgifter er alt, hvad du bruger. Mens vi diskuterede gratis ressourcer, afslørede vi, at du bruger penge, tid og kræfter i processen. Dette gælder også for intern dataindsamling.

I sidste ende ville du ende med at bruge på at betale dine medarbejdere, dataforskere, annotatorer, kvalitetssikringsprofessionelle og mere. Du vil også bruge på abonnementer på annotationsværktøjer og

vedligeholdelse af CMS, CRM og andre infrastrukturudgifter.

Desuden er datasæt bundet til at have bias og nøjagtighedsproblemer, som du skal bruge for manuelt at få dem sorteret. Og hvis du har et nedslidningsproblem i dit AI-træningsdatateam, skal du bruge på at rekruttere nye medlemmer, orientere dem om dine processer, træne dem til at bruge dine værktøjer og mere.

Du vil ende med at bruge mere, end hvad du i sidste ende ville tjene på længere sigt. Der er også anmærkningsudgifter. På ethvert givet tidspunkt er de samlede omkostninger ved at arbejde med interne data:

Påløbne omkostninger = Antal annotatorer * Pris pr. annotator + platformsomkostninger

Hvis din AI-træningskalender er planlagt til måneder, så forestil dig de udgifter, du konsekvent ville afholde. Så er dette den ideelle løsning til dataindsamlingsproblemer, eller er der noget alternativ?

Fordele ved en end-to-end AI Data Collection-tjenesteudbyder

Der er en pålidelig løsning på dette problem, og der er bedre og billigere måder at erhverve træningsdata til dine AI-modeller på. Vi kalder dem uddannelsesdatatjenesteudbydere eller dataleverandører.

De er virksomheder som Shaip, der specialiserer sig i at levere datasæt af høj kvalitet baseret på dine unikke behov og krav. De fjerner alle de besvær, du møder i dataindsamlingen, såsom at hente relevante datasæt, rense, kompilere og kommentere dem og mere, og lader dig kun fokusere på at optimere dine AI-modeller og algoritmer. Ved at samarbejde med dataleverandører fokuserer du på ting, der betyder noget, og på dem, du har kontrol over.

Derudover vil du også fjerne alle besværet forbundet med at hente datasæt fra gratis og interne ressourcer. For at give dig en bedre forståelse af fordelene ved en end-to-end dataudbyder, er her en hurtig liste:

- Udbydere af træningsdatatjenester forstår fuldstændigt dit markedssegment, use cases, demografi og andre detaljer for at hente de mest relevante data til din AI-model.

- De har muligheden for at hente forskellige datasæt, som finder passende til dit projekt, såsom billeder, videoer, tekst, lydfiler eller alle disse.

- Dataleverandører renser data, strukturerer dem og mærker dem med attributter og indsigter, som maskiner og algoritmer kræver for at lære og behandle. Dette er en manuel indsats, der kræver omhyggelig opmærksomhed på detaljer og tid.

- Du har fageksperter, der tager sig af at kommentere vigtige oplysninger. Hvis din produktanvendelse for eksempel er i sundhedsområdet, kan du ikke få den kommenteret fra en ikke-sundhedsprofessionel og forvente nøjagtige resultater. Med dataleverandører er det ikke tilfældet. De arbejder med SMV'er og sikrer, at dine digitale billeddata er korrekt kommenteret af industriveteraner.

- De tager sig også af dataafidentifikation og overholder HIPAA eller andre branchespecifikke overholdelser og protokoller, så du holder dig væk fra enhver og alle former for juridiske komplikationer.

- Dataleverandører arbejder utrætteligt på at eliminere skævhed fra deres datasæt og sikrer, at du har objektive resultater og slutninger.

- Du vil også modtage de nyeste datasæt i din niche, så dine AI-modeller er optimeret til optimal effektivitet.

- De er også nemme at arbejde med. For eksempel kan pludselige ændringer i datakravene kommunikeres til dem, og de ville problemfrit hente passende data baseret på opdaterede behov.

Med disse faktorer er vi overbevist om, at du nu forstår, hvor omkostningseffektivt og enkelt samarbejde med uddannelsesdataudbydere er. Med denne forståelse, lad os finde ud af, hvordan du kan vælge den mest ideelle dataleverandør til dit AI-projekt.

Indhentning af relevante datasæt

Forstå dit marked, use cases, demografi til at hente nyere datasæt, hvad enten det er billeder, videoer, tekst eller lyd.

Rens relevante data

Strukturer og tag dataene med attributter og indsigter, som maskiner og algoritmer forstår.

Databias

Eliminer skævhed fra datasæt, og sørg for, at du har objektive resultater og slutninger.

Datanotering

Fageksperter fra specifikke domæner tager sig af annotering af vigtige oplysninger.

Data-identifikation

Overhold HIPAA, GDPR eller andre branchespecifikke overholdelser og protokoller for at eliminere juridisk kompleksitet.

Sådan vælger du det rigtige AI-dataindsamlingsfirma

At vælge en AI-dataindsamlingsvirksomhed er ikke så kompliceret eller tidskrævende som at indsamle data fra gratis ressourcer. Der er kun et par simple faktorer, du skal overveje og derefter give hånd til et samarbejde.

Når du begynder at lede efter en dataleverandør, antager vi, at du har fulgt og overvejet, hvad end vi har diskuteret indtil nu. Men her er en hurtig opsummering:

- Du har en veldefineret use case i tankerne

- Dit markedssegment og datakrav er klart fastlagt

- Din budgettering er i orden

- Og du har en idé om mængden af data, du har brug for

Med disse punkter markeret af, lad os forstå, hvordan du kan lede efter en ideel udbyder af træningsdatatjenester.

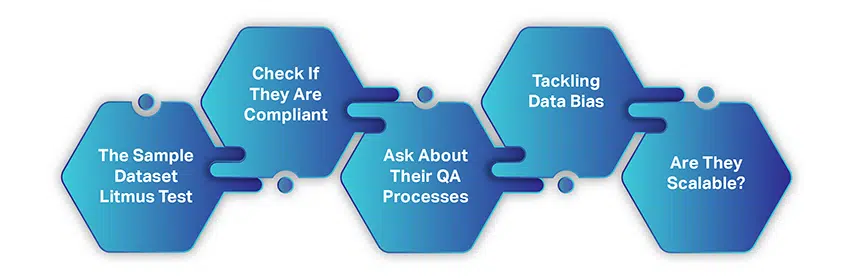

Prøvedatasæt lakmustest

Før du underskriver en langsigtet aftale, er det altid en god idé at forstå en dataleverandør i detaljer. Så start dit samarbejde med et krav om et eksempeldatasæt, som du betaler for.

Dette kunne være en lille mængde datasæt til at vurdere, om de har forstået dine krav, har de rigtige indkøbsstrategier på plads, deres samarbejdsprocedurer, gennemsigtighed og mere. I betragtning af det faktum, at du ville være i kontakt med flere leverandører på dette tidspunkt, vil dette hjælpe dig med at spare tid på at beslutte en udbyder og endelig finde ud af, hvem der i sidste ende er bedre egnet til dine behov.

Tjek, om de er kompatible

Som standard overholder de fleste udbydere af træningsdatatjenester alle lovmæssige krav og protokoller. Men for at være på den sikre side, forhør dig om deres overholdelse og politikker og indsnævre dit valg.

Spørg om deres QA-processer

Processen med dataindsamling i sig selv er systematisk og lagdelt. Der er en lineær metode, der implementeres. For at få en idé om, hvordan de fungerer, skal du spørge om deres QA-processer og spørge, om de datasæt, de henter og annoterer, er bestået gennem kvalitetstjek og revisioner. Dette vil give dig en

idé om, hvorvidt de endelige leverancer, du vil modtage, er maskinklare.

Håndtering af databias

Kun en informeret kunde ville spørge om bias i træningsdatasæt. Når du taler med uddannelsesdataleverandører, så tal om databias, og hvordan de formår at eliminere bias i de datasæt, de genererer eller anskaffer. Selvom det er sund fornuft, at det er svært at eliminere bias fuldstændigt, kan du stadig kende de bedste praksisser, de følger for at holde bias i skak.

Er de skalerbare?

Engangsleverancer er gode. Langsigtede leverancer er bedre. Men de bedste samarbejder er dem, der understøtter dine forretningsvisioner og samtidig skalerer deres leverancer med din stigende

krav.

Så diskuter, om de leverandører, du taler med, kan skalere op med hensyn til datavolumen, hvis der opstår et behov. Og hvis de kan, hvordan vil prisstrategien ændre sig i overensstemmelse hermed.

Konklusion

Vil du vide en genvej til at finde den bedste udbyder af AI-træningsdata? Kom i kontakt med os. Spring alle disse kedelige processer over, og arbejd sammen med os for at få de mest højkvalitets og præcise datasæt til dine AI-modeller.

Vi markerer alle de felter, vi har diskuteret indtil videre. Efter at have været en pioner på dette område, ved vi, hvad der skal til for at bygge og skalere en AI-model, og hvordan data er i centrum for alting.

Vi mener også, at Købervejledningen var omfattende og opfindsom på forskellige måder. AI-træning er kompliceret som det er, men med disse forslag og anbefalinger kan du gøre dem mindre kedelige. I sidste ende er dit produkt det eneste element, der i sidste ende vil drage fordel af alt dette.

Er du ikke enig?